什么是Ollama

Ollama是一个专为在本地环境中便捷部署和运行大型语言模型(LLMs)而设计的框架或工具,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如Llama2。这个框架简化了在Docker容器内部署和管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。

Ollama功能概述

目标与定位:Ollama旨在简化在个人计算机(尤其是笔记本电脑或工作站)上使用大型语言模型的过程,使得非专业用户也能轻松地在本地部署和交互这些通常需要大量计算资源的模型。

Docker容器支持:Ollama利用Docker技术来封装和管理LLM的运行环境。这意味着用户无需手动配置复杂的软件依赖和环境变量,而是通过Docker容器一键部署模型,确保了模型运行的一致性和便携性。

促进者(Facilitator)管理:Ollama可能涉及“促进者”这一概念,这可能指的是它能够协助管理与LLM交互的接口或服务,使得用户可以方便地通过API、命令行工具或其他应用程序接口与模型进行通信。

易用性与快速部署:Ollama强调其用户友好性和快速安装特性。根据描述,它提供简洁的安装流程,对于某些操作系统(如macOS),用户可以直接下载并快速设置,实现本地大模型的即时可用。

生态建设与社区支持:提到Ollama有逐渐成熟的生态系统,意味着它可能有活跃的开发者社区、丰富的插件或扩展、详细的文档教程以及用户论坛等支持资源,有助于用户更好地集成和定制Ollama以满足特定需求。

与ChatGPT等LLMs的关系:虽然Ollama本身不是具体的LLM,但它与ChatGPT等知名大模型技术的发展密切相关,因为它是为方便用户在本地使用这类先进NLP技术而创建的工具。OpenAI的ChatGPT是此类技术的成功案例之一,而Ollama则致力于让更多人能够在自己的设备上直接利用类似的技术。

所以说,Ollama是一个专注于本地部署和管理大型语言模型的工具,通过利用Docker容器化技术,提供易于使用的界面和安装流程,使得非专业人士也能在本地环境中便捷地利用先进的自然语言处理能力,如ChatGPT背后的技术。随着其生态系统的不断发展,Ollama有望进一步降低使用大型语言模型的技术门槛,推动相关技术在更广泛的用户群体中得到应用。

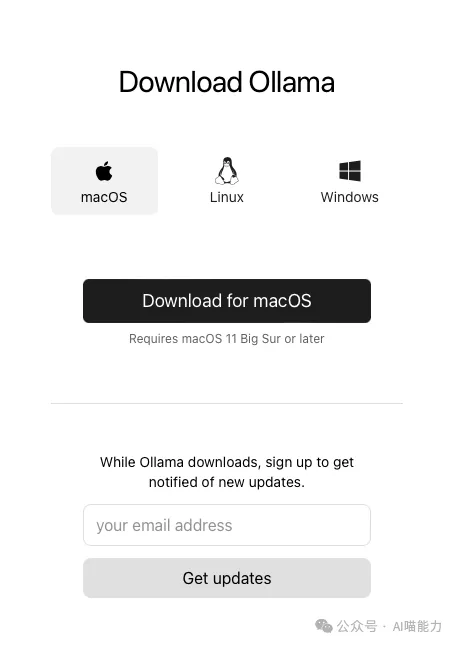

下载Ollama安装文件

下载地址:https://ollama.com/download

选择 Windows,单击 “Download for Windows (Preview)” 进行下载

安装

安装就比较简单,就像安装普通软件一样双击OllamaSetup.exe安装

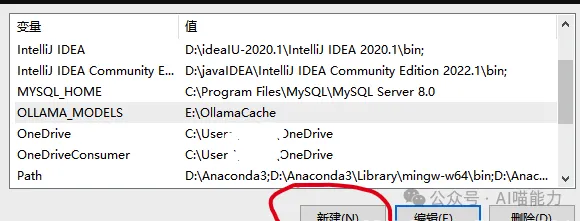

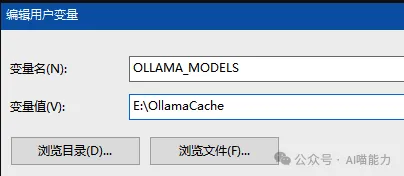

配置环境变量

Ollama下载的模型默认保存在C盘,但是建议大家修改默认路径,节约内存,毕竟模型文件太大了。

进入我的电脑,右击——>属性——>高级设置——>环境变量

保存之后重启电脑生效

使用

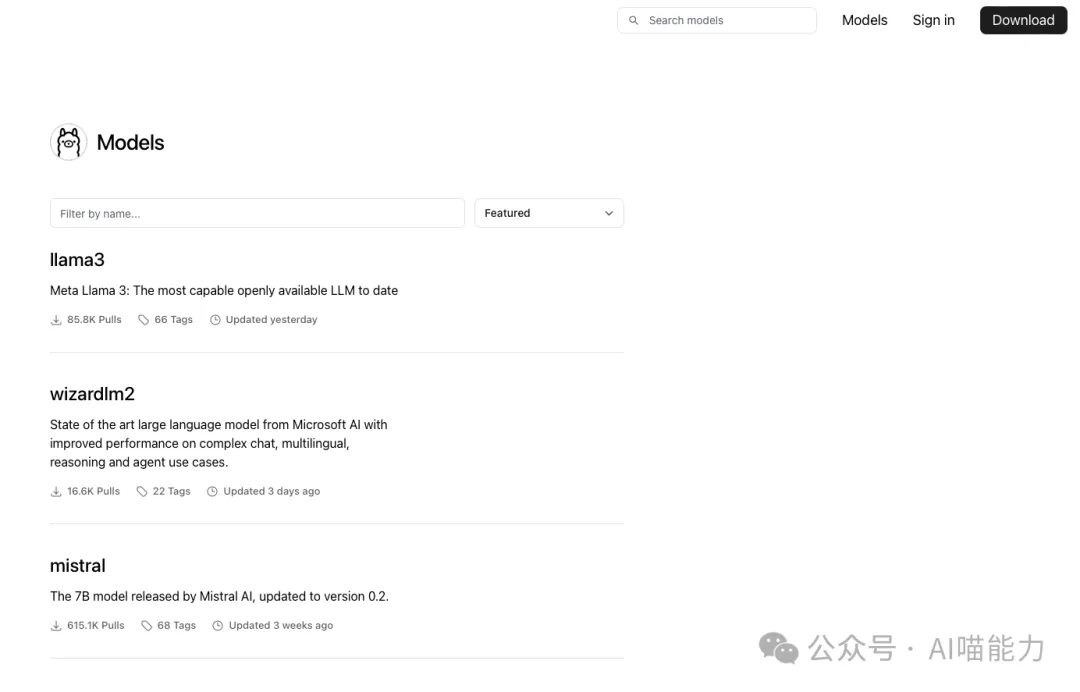

访问官方模型库,找到你想使用的模型

官方模型库:https://ollama.com/library

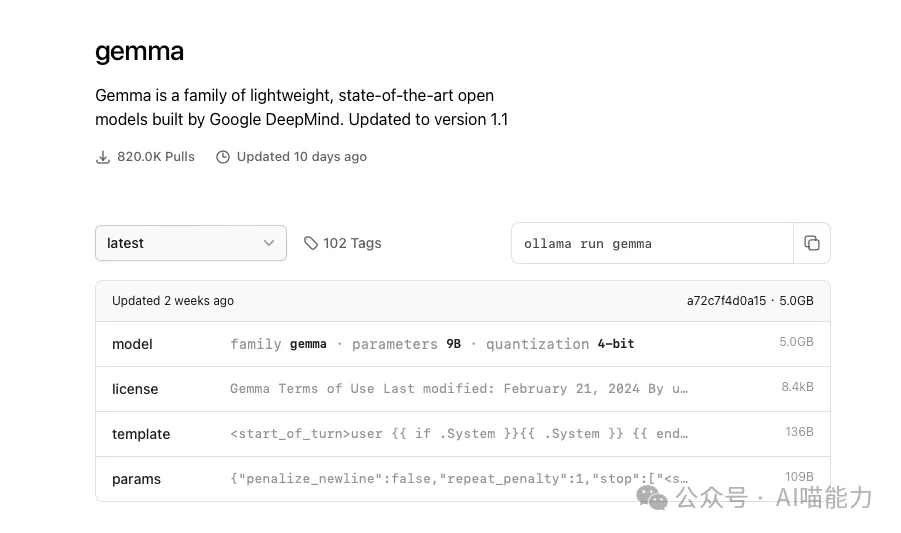

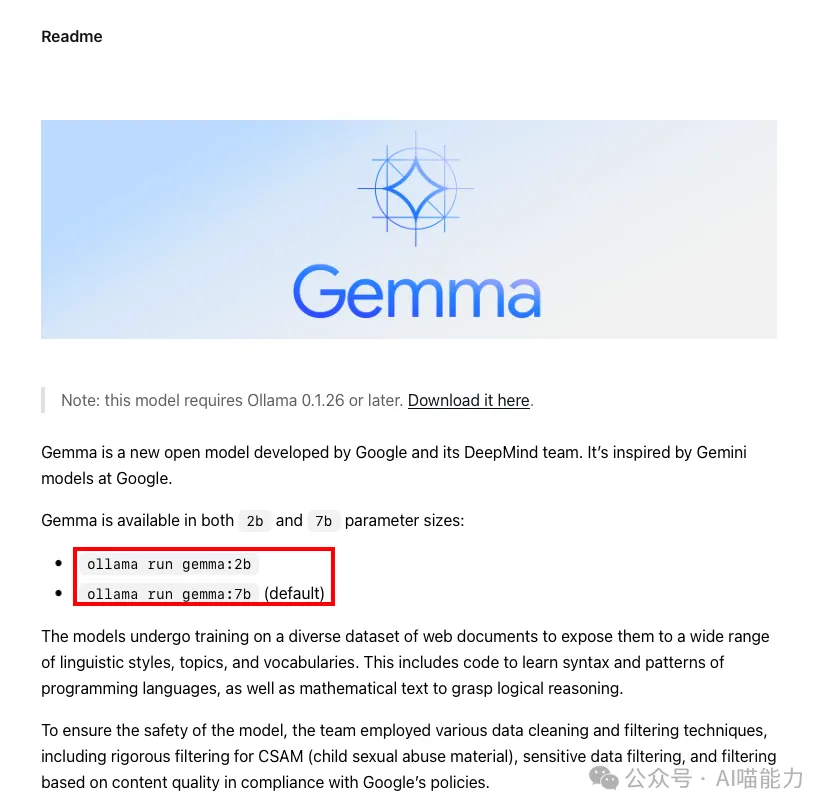

这里以gemma为例

往下翻看到Readme

复制红框中的命令在cmd或powershell中运行

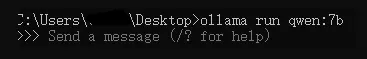

当出现Send a nessage即可开始模型的使用

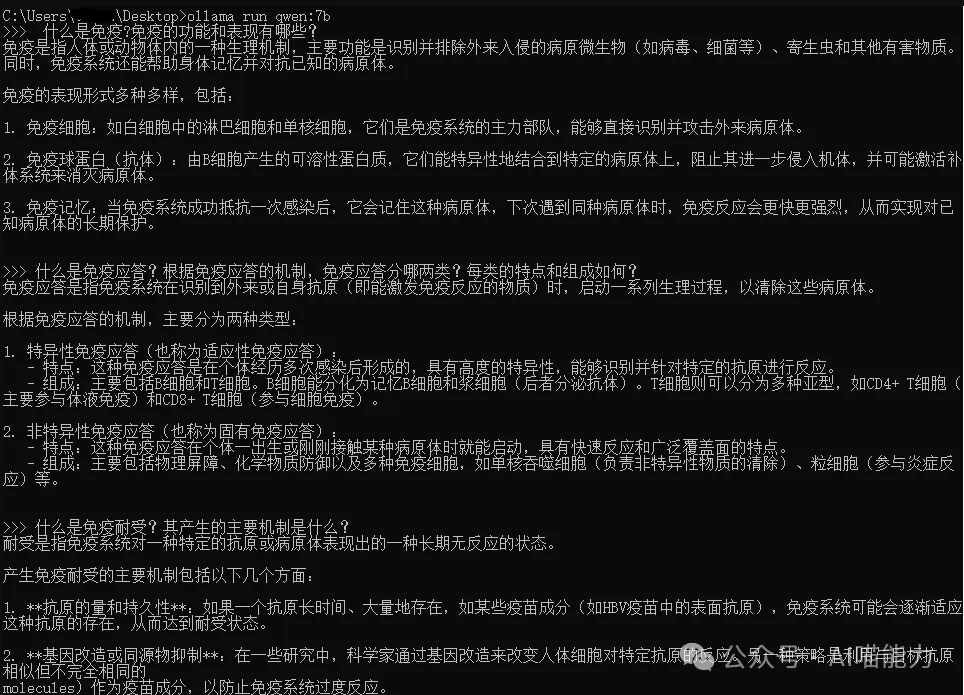

qwen-7b效果图:

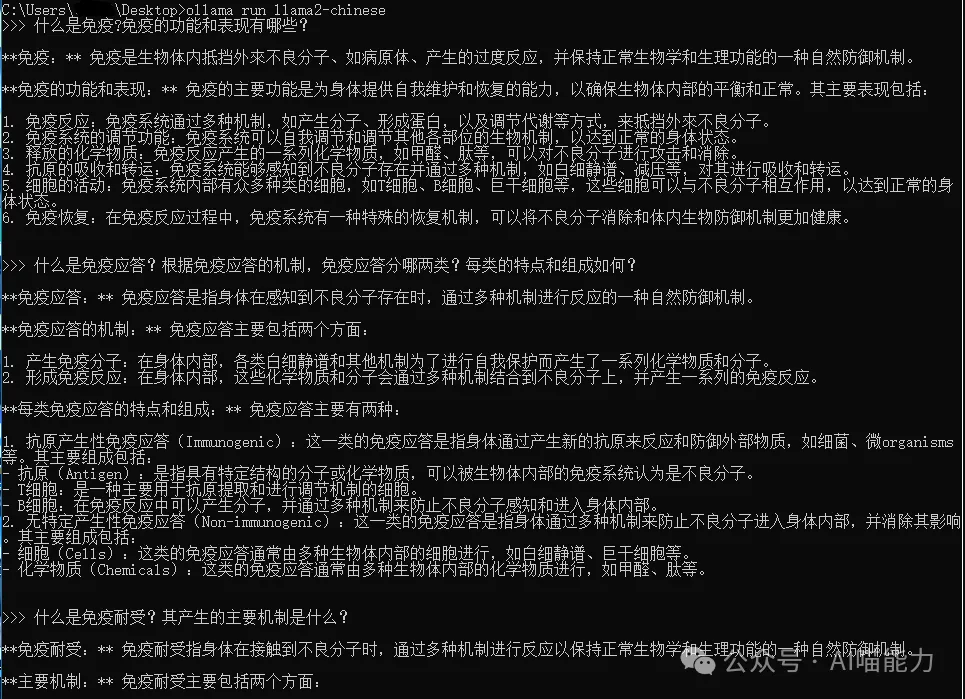

llama2-chinese效果图: