还记得我们在 欧洲公司用GPT4的思路打败了GPT3.5!

提到的Mixtral-8*7B MOE模型吗?

目前,这个8专家模型已经在开源社区杀疯了。

而且,更加炸裂的是,它直接打开了开源模型应用的天花板。

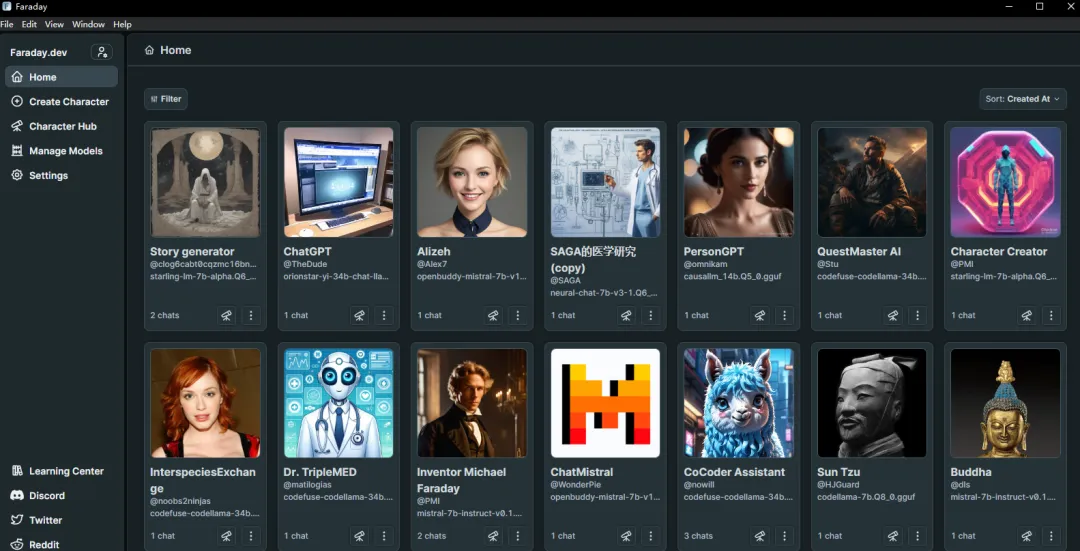

昨天,我们给大家介绍了faraday: 【普通人用AI】如何在家用PC使用本地大模型之法拉第(faraday)篇

今天,我们给大家介绍的是能够在本地当服务器,把Mixtral-8*7B MOE模型跑起来的LMSTUDIO!

和faraday一样,对用户非常友好。可以直接下载。

和faraday一样,它们属于基于llama-cpp底层的推理引擎,可以帮助你在本地电脑上运行各种AI大模型。

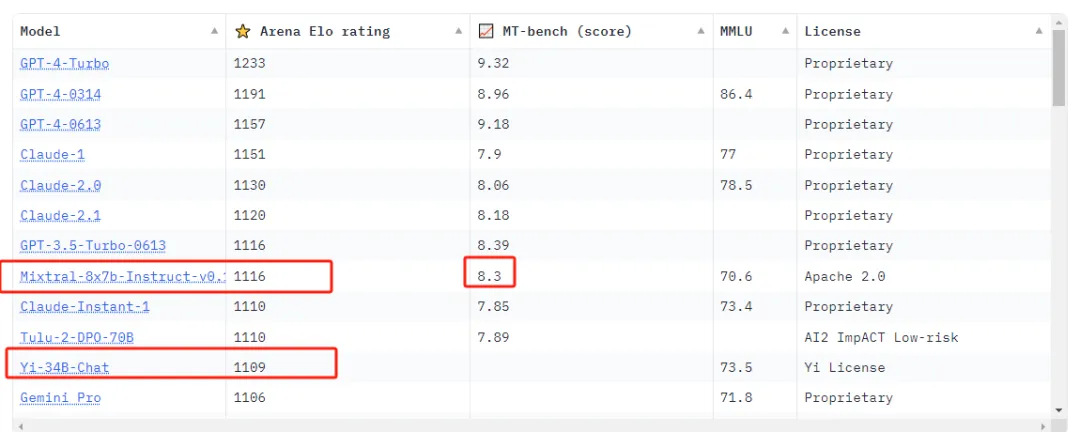

比如,上图我们跑的就是 Mistral-7B-Instruct-v0.2模型,它也是目前最强的7B模型了。不仅战胜了LLAMA2-70B,甚至在某些能力上还打败了我们最近评价很高的YI-34B。

所以,Mixtral 8*7B MOE,基本被大家认为是有望在不久经过社区迭代,成为最接近GPT4的本地模型存在!

而最让人激动的是,虽然Mixtral-8*7B MOE 模型正常体积高达89G,但经过量化之后,它的体积减少到了32G。

32G,仍然是一张4090也装不下。

但是,在LMSTUDIO,通过用显存和内存分担的机制;模型得以被加载!

这时,实际上要用到超过30G的内存。实际的内存占用也达到了60G以上。

这个时候,我的3090和E5-2666V3 CPU都是参与推理的。

不管怎么样,它还是跑起来了。而且,在平替GPT3.5的这个初级目标上,它做得确实还不错。

所以,我们也可以就此对最近火起来的AI PC概念有一个非常直观和明确的认知。

所谓AI PC,其实并没有多神秘;主要也还是硬件厂家特别是英特尔为14代酷睿提出的新概念。

简单来说,就是通过软硬件优化,让PC也能跑起来大模型。

这里面,硬件的优化主要是14代酷睿带有NPU的处理器以及高速DDR5内存,让本地模型推理能力尽量提升起来;摆脱对英伟达显卡的依赖。

而软件方面,则是微软的WIN12 copilot,以及内置在操作系统里面的AI模型。

但我们真的要为AI PC换代吗?

其实并不是绝对的。实际上,无需升级换代AI PC,基于FARADAY和 LMSTUDIO这样的推理软件,我们在很多老电脑上,稍微升级硬件,把软件配好也能把目前迭代得很出色的7B模型跑得很好;加上非常繁荣的社区模型,基本实现了在本地平替GPT3.5的方案了。

目前,我们推荐的能跑AI的本地方案是,英特尔8代酷睿以上, 32G内存;硬盘也需要1T以上固态了。

最后我们要说的是,,Mixtral-8*7B MOE 这种模型虽然能力很强,但欧洲人在中文领域并没有优化,也不可能帮我们专门做优化;客观上对中国人的增益不高(中文增强这活还得自己来)。

在自己训练微调模型方面,虽然大部分企业很踊跃,但国内模型刷分的情况很严重,社区的繁荣度也并不高。客观的说,中文大模型近期进步除了YI-34B之外乏善可陈,近期差距有点拉大了的感觉。

大模型测评【普通人用AI】如何在家用PC使用本地大模型之法拉第(faraday)篇

每月50块的文心一言4.0VIP会员来了!它能取代GPT4吗?

想让它全自动做漫画?还早!——本地试用国产多模态大模型浦语·灵笔实录

【普通人用AI】三大国产AI APP,能画图能语音对话,哪个更适合当你的数字助理?

你的AI大模型自由已来!中国大模型全面开放,谁能超越GPT4?

【长测】真干活行不行?国产大模型们和chatGPT结合AI绘画的真实工作体验

喜欢本文,请在右下角给我们点下“好看”