文章主题:算法层面, 模型架构, LLaMA, RoPE

【点击】加入大模型技术交流群

之前在baichuan-7B发布的时候,有对其进行技术剖析。而baichuan-13大模型主要还是参考LLaMA进行的改进。

在算法层面:模型架构基本与 LLaMA 一致。

在位置编码优化方面,LLaMA采用了旋转式位置编码RoPE技术,而我国自主研发的baichuan-13B则运用了ALiBi线性偏置技术。相较于RoPE,ALiBi在计算量上更为高效,从而在很大程度上提升了推理性能。具体而言,与传统的LLaMA-13B模型相比,baichuan-13B的平均推理速度(以tokens/s为单位)实现了31.6%的提升。

在数据层面:用于提升模型的效果以及解码效率。

分词改进:词表大小为64K(使用2000万条以中英为主的多语言语料训练分词模型,显著提升对于中文的压缩率),而LLaMA词表大小为32K。数据集改进:针对13B模型使用了大约 1.4T 中英 tokens 进行训练(基于开源的中英文数据和自行抓取的中文互联网数据以及部分高质量知识性数据进行的数据清洗),而 LLaMA 13B 使用 1T 英文 tokens 进行训练。在技术层面:用于提升训练稳定性和吞吐量。

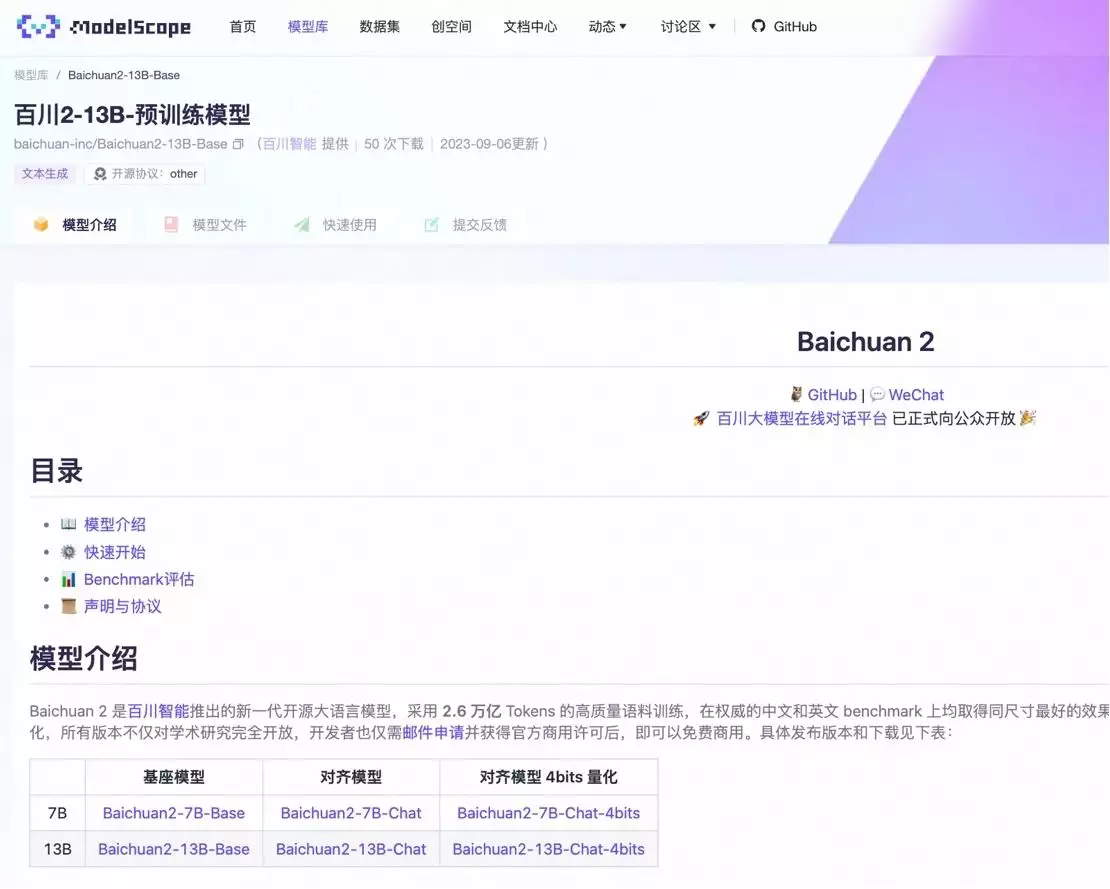

算子优化技术:采用更高效算子,如 Flash-attention,NVIDIA apex 的 RMSNorm 等。算子切分技术:将部分计算算子进行切分,减小内存峰值。混合精度技术:降低在不损失模型精度的情况下加速计算过程。训练容灾技术:训练平台和训练框架联合优化,IaaS + PaaS 实现分钟级的故障定位和任务恢复。通信优化技术,具体包括:采用拓扑感知的集合通信算法,避免网络拥塞问题,提高通信效率。根据卡数自适应设置 bucket size,提高带宽利用率。根据模型和集群环境,调优通信原语的触发时机,从而将计算和通信重叠。在此次发布的更新中,我们很高兴地宣布了两个重要产品的推出:Baichuan-13B-Base,这是一款基于预训练基础的语言大型模型;以及Baichuan-13B-Chat,这是一款专为基本型大模型设计的有监督微调对话大型语言模型。

在此次发布中,我们不仅开放了 int8 和 int4 的量化版本,而且这些版本在效果上与非量化版本相差无几。这意味着在降低部署所需机器资源的同时,我们并未牺牲太多性能。因此,现在 int8 和 int4 可以在如 Nvidia 3090 这样的消费级显卡上运行,而无需担心性能问题。

原内容表达较为简洁,但我们可以通过更深入的分析,以更具说服力的方式呈现。以下是改写后的内容:此外,本次推出的13B大模型依然保持开源免费的特性,同时具有商用的潜质。关于百川大模型为何选择开源的方式,我认为这主要归因于以下几个方面的考虑。

第一,大模型赛道实在是太卷了,如果不开源可商用,完全没有竞争力。

作为一名专业的文章写作高手,我将重新组织原文内容,确保其表达清晰且信息完整。首先,对于一家大型模型初创公司而言,提升自身影响力至关重要。开源项目能够迅速吸引大量粉丝,进而针对这些粉丝进行下游任务的创新以及生态的拓展和加强。在这方面,国际上的先进经验值得借鉴。例如,全球领先的OpenAI和谷歌在大模型领域采取了封闭式开发策略,而相对落后的Meta则选择了开放源代码的道路(从初始的不成功项目OPT到后来大放异彩的LLaMA)。尽管LLaMA的开源程度并不完美,但在网友们的支持下,它的形象得到了很好的维护。显然,LLaMA目前是开源大模型领域最成功的案例。

作为一家大型语言模型初创公司,我们的业务模式与百度、360等知名企业有所不同。我们无法直接将自身产品化,而是必须探索可行的商业模式和潜在合作伙伴,以便将我们的技术与实际应用场景相结合。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!