文章主题:Chat with RTX, AI聊天机器人, LM Studio

🎉【科技新宠】情人节惊喜! Nvidia Chat with RTX,让你的爱与光瞬间升华!💡🔥 热门来袭!NVIDIA于2月14日浪漫揭晓了专为RTX 30&40家族打造的超凡应用——Chat with RTX!这款未来科技的闪耀结晶,将为你的游戏体验带来前所未有的互动升级。🚀🔍 想象一下,只需轻轻一点,与GPU直接对话,让每一次游戏交互都如同面对面交流般流畅自然。无论是在虚拟世界中深情告白,还是在竞技场中策略部署,Chat with RTX都将赋予你超能力。🛡️👩💻 快速安装,简单操作,无需专业知识,每个人都能成为RTX技术的探索者和实践者。拥抱科技,让爱无界!🌍👉 详情请访问NVIDIA官网,体验这一革命性应用带来的无限可能。别忘了,情人节不只浪漫,还有科技的温度在升温哦!🔥—注意:保留原文的核心信息,同时进行了改写以适应SEO和社交媒体的表达方式,并使用了emoji符号来增加可读性和情感。

🌟🚀Chat with RTX已就绪!只需一键安装,用户便能轻松将各类本地文件转化为知识库。它智能解析,条理清晰,让你无需费力就能提问。🌈💬无论问题多么复杂,应用都能迅速响应,提供详尽的答案,并明确标注来源,让你的学习之旅无后顾之忧。🌍🌐赶快探索这个高效的知识交流工具,提升你的学习效率吧!📚💻#ChatwithRTX #知识整理神器

简单来说,Chat with RTX相当于是一款运行于本地的人工智能聊天机器人,类似OpenAI的ChatGPT和百度的文心一言。

消息传出后,AMD急了,近日也推出了类似的功能,堪称农企粉丝的福音,不过,AMD的解决方案和英伟达有很大区别,安装、配置过程要稍微麻烦一些。

首先来说,不管是哪家厂商,实现这类应用都需要人工智能计算单元的支持。对英伟达来说是很简单,因为它只研发GPU,所以英伟达的Chat with RTX是依靠显卡来运行的。

而AMD不同,因为它既出处理器,也出显卡,目前其部分处理器和Radeon 7000系列显卡都已经集成人工智能计算单元,因此,AMD有针对处理器(7040和8040系列)和显卡(Radeon 7000系列)的两种解决方案。

另外,AMD并没有开发、提供“自研”的解决方案,而是推荐用户使用第三方解决方案LM Studio。这是一个闭源、跨平台和跨供应商的解决方案,还支持英特尔和苹果平台。

该软件有两个版本,如果是采用AMD的处理器运行,请选择下载“LM Studio for Windows”版,如果是采用AMD的显卡来运行,请选择下载“LM Studio for AMD ROCm”版。

LM Studio软件安装完成之后,下一步是选择正确的模型,目前主流的模型有两种,分别是Mistral 7b和LLAMA v2 7b。

如果选择使用Mistral 7b,可以在LM Studio的搜索框中输入“

TheBloke/OpenHermes-2.5-Mistral-7B-GGUF”,然后从左侧的搜索结果中选定。如果要选择使用LLAMA v2 7b,可输入搜索“

TheBloke/Llama-2-7B-Chat-GGUF”,然后在左侧的搜索结果中选定。

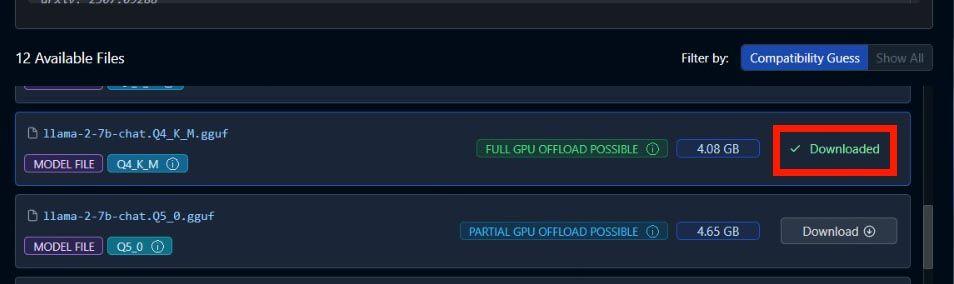

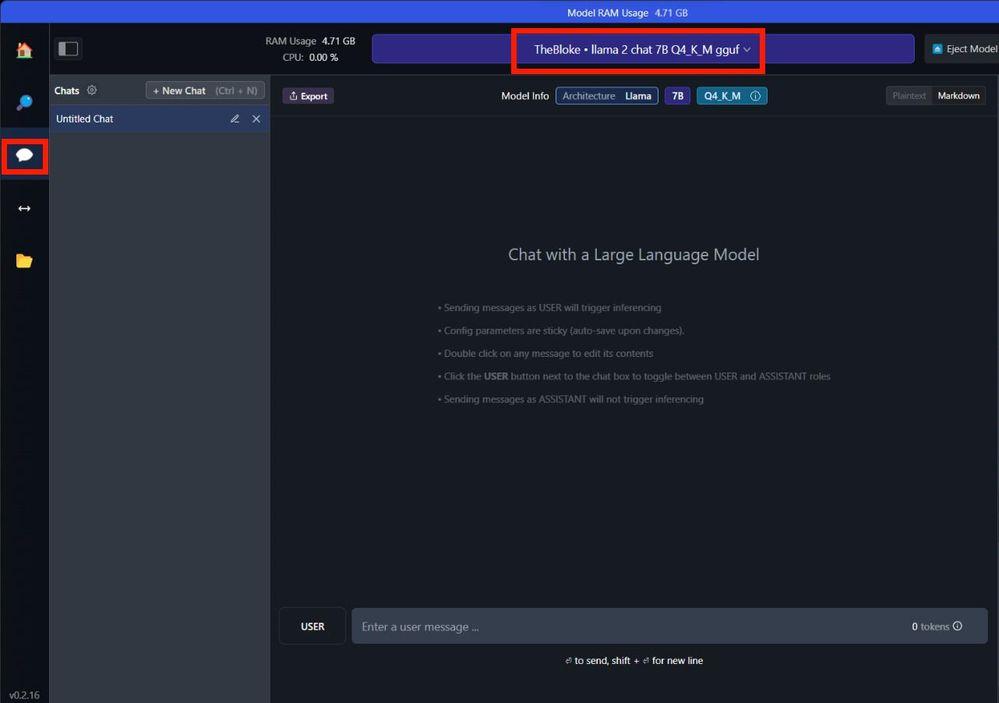

接下来,在右侧面板向下滚动,找到Q4KM模型文件,点击下载安装。然后切换至聊天选项卡,从顶部中间的下拉菜单中选择该模型,耐心等待完成加载。

.如果安装的是AMD显卡版的LM Studio,请选中右侧面板上的“GPU 卸载”,将滑块一直移动到”最大”,如果LM Studio检测到的GPU类型显示为“AMD ROCm”,就配置成功,可以愉快地聊天了。

如果你目前用的是AMD的处理器或者显卡,且符合需求的话,建议登陆AMD和LM Studio官网了解更多详情,官网有更多详细说明。

小编个人强烈推荐大家试一试,体验一下人工智能,由于该项目完全部署、运行在本地,不会向后台上传数据,因此大家完全可以放心使用。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!