文章主题:生成式AI, LLM, Qwen

设置一个聪明的聊天机器人,你应该是!从了解生成式 AI 和 LLM(大型语言模型)开始。

Generative AI

🎨🚀探索未来创意之源:🔥生成式AI引领内容革命!🌍🔍在人工智能的广阔领域中, generarative AI 打破常规,以其创新力驱动创作边界无限扩展!💻它以生成模型为核心,通过深度学习的力量,从海量数据中提取隐形模式和联系,仿佛拥有无尽的创造力。🎨无论是文学的细腻笔触,🔥音乐的热情旋律,还是视觉艺术的震撼瞬间,都能被精准模拟并超越。🔍这项技术不仅挑战了人类的创作极限,还能为各行业带来颠覆性的变革。它悄然融入新闻报道、营销文案乃至个性化推荐中,悄无声息地提升内容的质量和吸引力。💼🌍但请注意,这并非取代人类智慧,而是与之携手,共同编织一个创新与真实交织的世界。👩💻如果你是一名创作者,不妨拥抱这一科技,让想象力在数字世界中自由翱翔!SEO优化提示:使用关键词”生成式AI”, “内容革命”, “深度学习”, “创意边界”, “行业变革”, “个性化推荐”等。

生成模型的类型

生成对抗网络 (GAN):一种神经网络架构,其中同时训练两个模型(生成器和判别器)。生成器在鉴别器评估它们时创建新的数据实例。该过程会产生越来越令人信服的输出。变分自动编码器 (VAE):这些模型会生成与输入数据类似的新实例。它们通常用于图像生成。Transformers:GPT(生成式预训练转换器)等转换器模型最初是为 NLP 任务设计的,可以生成连贯且上下文相关的文本。它们也被调整为其他类型数据的生成任务。应用

内容创作:生成式 AI 可以制作原创艺术作品、撰写故事或文章、创作音乐以及为游戏和模拟创建虚拟环境。数据增强:它可以为机器学习模型生成额外的训练数据,有助于提高其准确性。个性化:算法可以根据个人喜好定制内容,提高用户参与度。药物发现:生成模型可以为药物提出新的分子结构,这些药物可能对特定疾病有效。挑战

质量管理:确保生成的内容符合质量标准,并且训练数据中没有偏差。计算要求:训练生成模型通常需要强大的计算能力和大型数据集。可解释性:了解这些模型如何做出决策并生成输出可能具有挑战性,这会影响信任和可靠性。🌟🚀生成式AI持续爆发,拓宽了机器创新的疆界,带来了无数激动人心的可能性,同时也伴随着复杂而紧迫的管理课题。💼🔍我们必须审慎应对,既要拥抱其革新力量,也要妥善解决由此带来的伦理与合规问题。🌍🌈

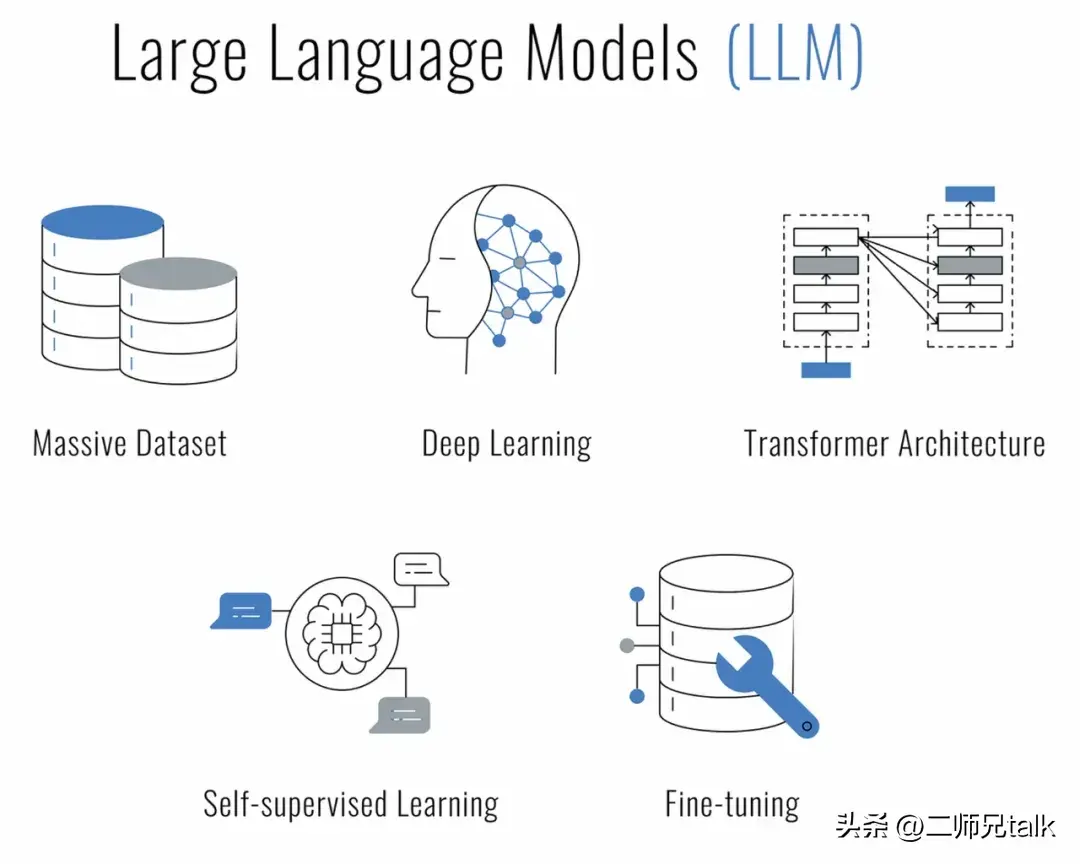

LLM

什么是大型语言模型 (LLM)?它们是一种基于深度学习技术的人工智能,旨在理解、生成和处理人类语言。它们之所以被称为“大”,是因为它们由数百万甚至数十亿个参数组成,这使它们能够捕获各种语言细微差别和上下文。

LLM 在大量文本数据上进行训练,并使用 Transformer 神经网络等架构,该架构可以处理数据序列(如句子),并在进行预测时关注序列的不同部分。这使得它们对于一系列自然语言处理 (NLP) 任务特别有效,例如:

文本生成:LLM 可以写论文、创作诗歌或根据给他们的提示生成代码。翻译:它们能够高度准确地翻译各种语言之间的文本。问答:LLM 可以通过理解上下文和提取信息来提供问题的答案。摘要:他们可以将长文档浓缩成简洁的摘要。情感分析:LLM 可以确定文本背后的情感,例如确定评论是正面的还是负面的。为什么选择 Qwen?

您是否正在寻找一个可以聊天、创建内容、总结、编码等功能,同时尊重您的隐私权的 AI?别再犹豫了,Qwen 聊天模型可以将您的数据中心转变为安全的 AI 交互堡垒。

Qwen 不是普通的聊天机器人。它建立在一个庞大的语言模型之上,并在惊人的 3 万亿个多语言数据上进行了训练。这个人工智能奇迹可以复杂地理解英语和中文,并针对类似人类的交互进行了微调。

为什么选择 Qwen 的本地化服务?

在服务器上本地部署 Qwen 就是要控制。这是为了确保您进行的对话、处理的数据和承诺的隐私都属于您的权限。无论您是希望集成智能聊天系统的企业、热衷于 AI 研究的开发人员,还是只是渴望探索对话式 AI 界限的爱好者,Qwen 都是您的首选。

现在,你为什么要在本地托管这个 LLM?三个词:控制、速度和隐私。你把你的数据放在胸前,回复以闪电般的速度出现,你可以高枕无忧,因为你知道你的聊天机器人不会在公共服务中喋喋不休地谈论你的秘密。

开源和社区驱动

开源社区放大了人工智能的创新精神。为了保持这一传统,Qwen 聊天模型的完整源代码可以在 GitHub 上轻松获得,供任何有兴趣深入了解模型机制、为其开发做出贡献或只是将其用作学习资源的人使用。无论您是研究人员、开发人员还是 AI 爱好者,您都可以在 Qwen 上访问源代码。

开始之前:要点

在我们踏上这场科技之旅之前,让我们确保你已经把所有的鸭子都排成一排了:

带有 GPU 卡的 Linux 服务器——速度至关重要。Python 3.6 或更高版本 — 编程的基座。pip 或 Anaconda — 依赖包管理器。Git(可选)——适合那些喜欢从存储库中新提供的代码的人。NVIDIA 驱动程序、CUDA 工具包和 cuDNN — GPU 加速的三位一体。在哪里运行 Python 代码

无论你是 Visual Studio Code 的铁杆粉丝、PyCharm 爱好者,还是喜欢 Jupyter Notebooks 的交互式风格的人,用于与 Qwen 聊天的 Python 代码都非常灵活且与 IDE 无关。您所需要的只是一个支持 Python 的环境,您就可以让您的 AI 聊天伙伴栩栩如生。

这里有一个专业提示:如果您使用的是 VSCode,请利用内置终端无缝运行您的 Python 脚本。只需打开命令面板 (Ctrl+Shift+P),键入 Python:Run Python File in Terminal,然后让 VSCode 完成繁重的工作。您将在集成终端中看到 Qwen 的回复。

对于那些喜欢 PyCharm 的人来说,运行代码同样流畅。右键单击脚本,然后选择 Run script_name.py,然后观察 IDE 执行您与 Qwen 的对话。PyCharm 强大的工具和调试功能使其成为开发更复杂交互的绝佳选择。

它并没有就此结束——有大量的 IDE 和代码编辑器张开双臂欢迎 Python。选择最适合您工作流程的那个,然后开始聊天吧!

搭建环境

首先,让我们准备您的 Linux 服务器。确保您的软件包列表像晨风一样清新,并且 Python 和 pip 已准备好施展它们的魔力:

sudo apt update sudo apt install python3 python3-pip现在是秘密成分:虚拟环境。这就像有一个个人工作空间,你可以把事情弄得一团糟,而没有人对你大喊大叫来清理:

pip install –user virtualenv virtualenv qwen_env source qwen_env/bin/activate工具箱:安装依赖项

在我们让 Qwen 栩栩如生之前,您需要一些工具。可以把这看作是米其林星级餐的食材收集:

pip install torch torchvision torchaudio pip install transformers请记住将 PyTorch 与您的 CUDA 版本相匹配——这就像将美酒与正确的奶酪搭配一样。

觉醒 Qwen:模型初始化

说同一种语言:分词器

在Qwen赋予它们意义之前,单词只是单词。这就是分词器的用武之地,将你的沉思变成 Qwen 可以咀嚼的东西:

from transformers import AutoTokenizer tokenizer = AutoTokenizer.from_pretrained(“Qwen/Qwen-7B-Chat”, trust_remote_code=True)操作的大脑:模型

Qwen 的头脑很广阔,随时可以被你的谈话填满。以下是执行方法:

from transformers import AutoModelForCausalLM model = AutoModelForCausalLM.from_pretrained(“Qwen/Qwen-7B-Chat”, device_map=“auto”, trust_remote_code=True).eval()根据您的硬件,您可以选择不同的精度模式,如 BF16 或 FP16。这就像把你的吉他调到完美的音高。

与Qwen进行持续对话

现在是令人心跳加速的部分——是时候和 Qwen 聊天了!但在你被来回冲昏头脑之前,让我们谈谈一些至关重要的事情:对话连续性的艺术。

以下是您可以期待的那种 repartee 的先睹为快:

response, history = model.chat(tokenizer, “Greetings, Qwen! Hows life in the digital realm?”, history=None) print(“Qwen:”, response)在我们的开场白中,我们向 Qwen 打招呼时没有任何附加条件——也就是说,没有对话历史。通过设置 history=None,我们告诉 Qwen,“这是我们聊天的开始。Qwen 除了当前的提示之外别无他法,他将以新互动的新鲜感做出回应。

response, history = model.chat(tokenizer, “Any thoughts on the meaning of life, the universe, and everything?”, history=history) print(“Qwen:”, response)在这一轮中,我们传递了我们从上次交流中获得的历史。这就像递给 Qwen 一本日记,上面写着我们到目前为止谈论过的一切。在这种历史背景下,Qwen 可以做出一个不仅诙谐或深刻的回应,而且还与我们正在进行的对话相关联。这是与认识你的聪明的朋友聊天和向陌生人提问之间的区别。

为什么“历史”很重要:把历史想象成一条线,把我们谈话的珍珠串在一起。没有它,Qwen 的每一个回应都将是一颗孤立的珍珠,美丽而孤独。随着历史的发展,每一颗珍珠都牢固地打结到最后,创造出一串美丽而有凝聚力的对话。语境是对话中的王道,而历史是语境的承载者。保持对话流畅:就像在人际交往中一样,参考过去的评论、笑话或故事会让人开怀大笑。拥有对话历史的 Qwen 可以回忆和参考过去的交流,使聊天既持续又引人入胜。准备,设置,交谈!

现在,您已经了解了历史参数上下文的重要性,请启动该演示脚本并准备好与 Qwen 进行聊天。无论您是在讨论宇宙还是数字饼干的最佳配方,Qwen 都准备好以经验丰富的对话者的所有优雅来跟随您的对话线索。

此外,您可以启动该脚本并开始对话。这就像打开潘多拉魔盒,但你得到的不是混乱,而是令人愉快的戏谑:

python qwen_chat.py

总结

您已经像经验丰富的船长一样在AI部署的险恶水域中航行。Qwen 现在已经紧密地固定在您的服务器上,您的数据就像房屋一样安全。

探索 Qwen 的功能,为其开发做出贡献,并加入一个由志同道合的人组成的社区,他们热衷于推进 AI 对话的状态。

点赞关注 二师兄 talk 获取更多资讯,并在 头条 上阅读我的短篇技术文章

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!