文章主题:

什么是LM Studio

简单讲就是发现、下载和运行本地 LLM大模型。是一个免费的桌面软件工具,它使得安装和使用开源LLM模型非常容易

使用LM Studio可以干什么

🚀💻无需联网也能畅享LLM!👩💻📱掌握最新知识,只需一台设备。在全无网络干扰的环境中,深入学习,提升技能。无论是学术研究还是职业发展,离线LLM都能为你提供强大支持。让你的学习随时随地,不受束缚。🌍📚快来体验,开启你的知识之旅吧!#离线学习 #LLM笔记本电脑

🌟利用内置聊天界面或搭配OpenAI的本地服务器💡,轻松调用模型功能。🚀无需透露个人信息,确保隐私安全。让智能对话无缝融入你的应用体验。🌐无论何时何地,只需轻点几下,就能享受高质量的交互服务。🏆优化的语言处理,助力搜索引擎SEO,提升内容可见度。🌍让文字更生动,信息传递更高效。

🎉🚀提取超能文本!只需一行代码,轻松从[HuggingFace](https://huggingface.co/)一键获取模型文件!🚀🎉🚀无论你需要自然语言处理的魔法,还是对话系统的秘诀,HuggingFace的丰富资源总能满足你的需求。从预训练的大规模模型到定制化的解决方案,这里应有尽有。📚🔍只需简单复制粘贴模型链接,仓库就会自动为你加载最新、最热的文件。无需担心版本问题,一切都在掌控中!👩💻💻想要提升你的AI技能?别忘了探索他们的社区和教程,那里有无数高手分享心得,助你快速上手。💬📚记得,学习的同时也要保护版权哦!尽情享受知识的馈赠,但请尊重创作者的权利。💪💖

🎉新发现!🎓LLM应用主页上的亮点与深度学习课程,专为热衷学术的你量身打造!🔍探索最新、最前沿的专业知识,提升你的理论素养。👩🏫由行业专家引领,让你的学习之旅不再迷茫。立即加入,开启你的知识探索新篇章!🌐适用于所有对法律教育感兴趣的你,赶快行动吧!🏆原内容: – 请在我们的网站上注册以获取免费样品### Response:🎁免费福利来啦!🎉只需轻点一下,在我们网站上快速注册,即可享受独家样品优惠。👩💻探索产品深度,亲身体验其卓越品质。别犹豫了,立即行动,让惊喜与知识同行!🌐赶快加入我们的用户大家庭,提升你的体验!🏆原内容: – 联系我们以获取更多详细信息### Response:💡想要深入了解?只需点击这里,直接与我们取得联系。👩💼我们的专业团队随时待命,解答你的所有疑问。💌分享你的需求,我们会提供定制化的服务方案。立即行动,让我们一起深入探讨!🌐期待与你建立更紧密的连接!🤝

🌟【技术实力揭秘】🚀 以llama.cpp为核心,Ollama展现出强大的技术魅力!致敬背后的GG大神,他们的智慧与坚持引领行业发展。🏆

最低硬件要求

装有 macOS 13.6 或更高版本的 Apple Silicon Mac (M1/M2/M3)具有支持 AVX2 的处理器的 Windows/Linux PC(通常是较新的 PC)推荐使用 16GB+ 的 RAM。对于 PC,建议使用 6GB+ 的 VRAM。支持 NVIDIA/AMD GPU如何运行LM Studio

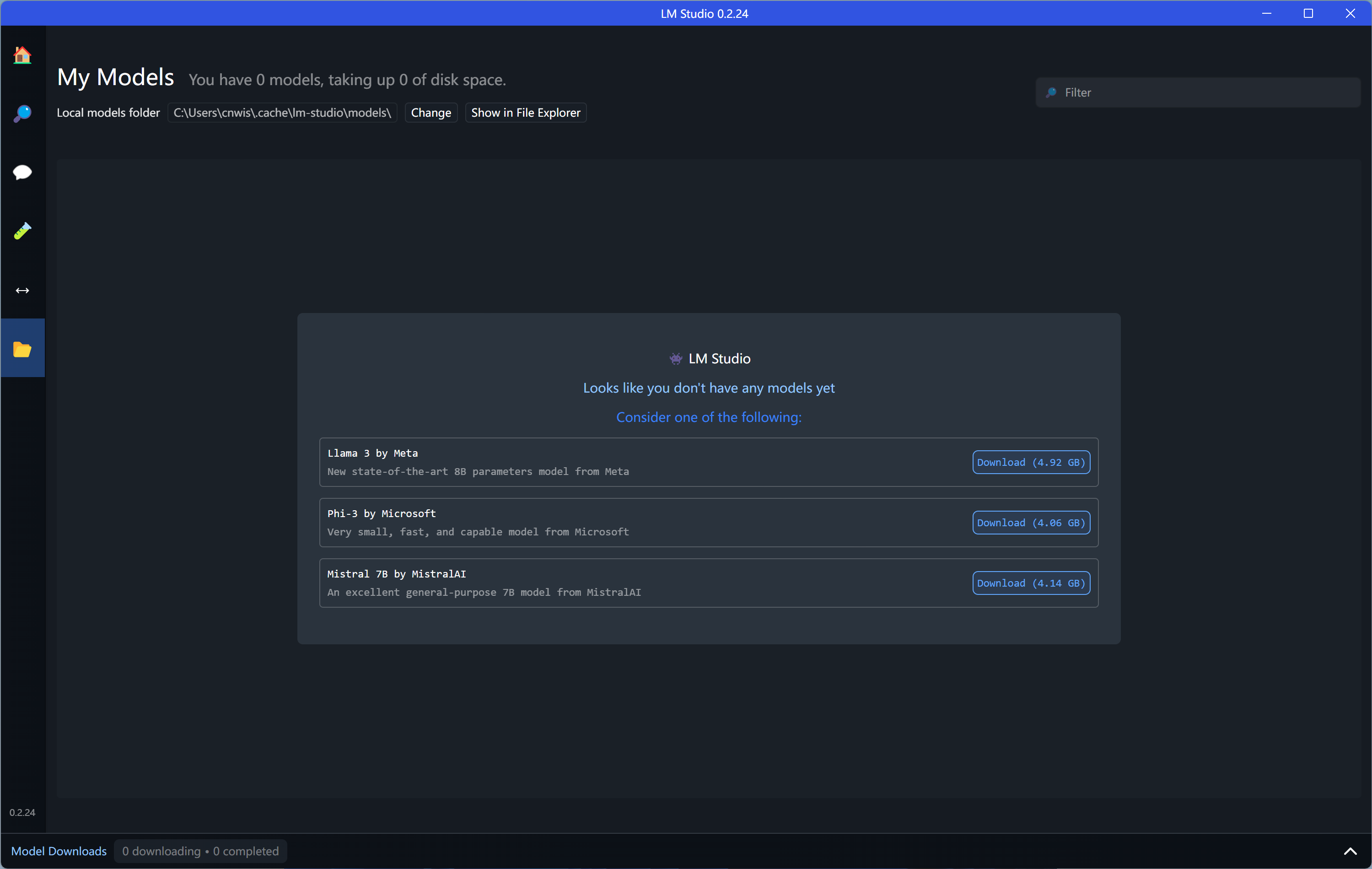

下载:https://lmstudio.ai以Windows11为例,直接点击安装包LM-Studio-0.2.24-Setup.exe安装即可,安装超快。首次安装会提示本机目前还没安装大模型,请先下载并安装一个,如下所示

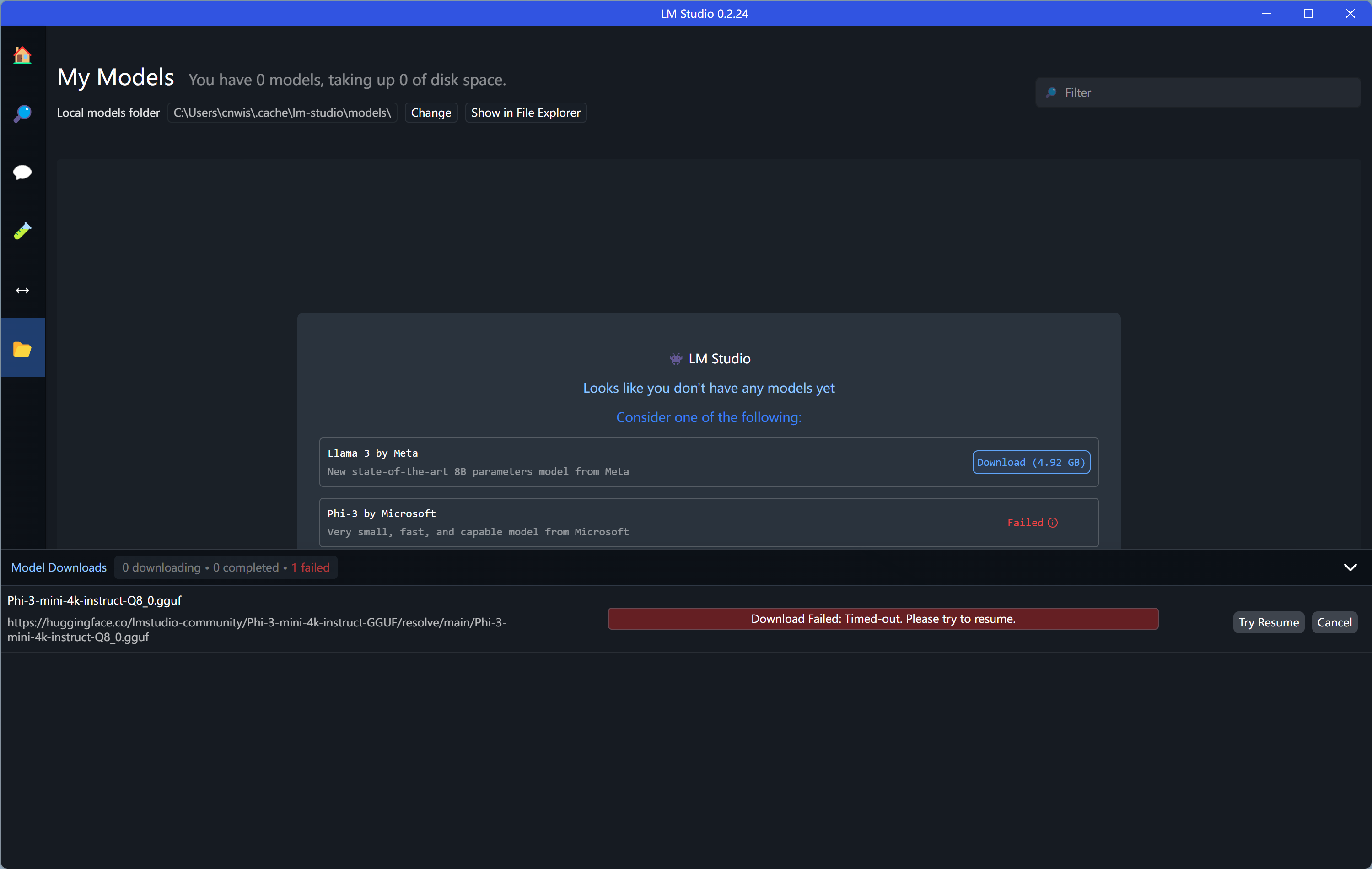

敲黑板:直接下载huggingface.co模型是不行的,会报错:

🌟当面临问题时,解决方案总是关键。🎯首先,明确问题本质,就像剥洋葱一样,逐层深入剖析。📚然后,查阅相关资料,智慧就在书页之间等待被发现。💡接着,尝试不同的角度,换个思路往往能柳暗花明。👥交流也是良策,分享经验,集思广益。🌐最后,行动起来,实践出真知。💪别忘了,每个挑战都是成长的机会,勇敢面对,你就是自己的英雄!🏆

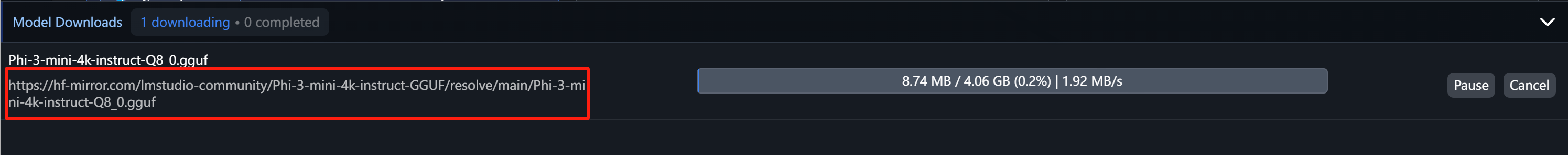

选择要下载的模型,报错,就是上图的结果,把程序关闭,用编辑器打开~/.cache/lm-studio/downloads.json 这个找到配置文件{ “downloadsMap”: [ [ “https://huggingface.co/lmstudio-community/Phi-3-mini-4k-instruct-GGUF/resolve/main/Phi-3-mini-4k-instruct-Q8_0.gguf”, { “status”: { “type”: “paused”, “pauseReason”: { “type”: “error”, “errorMessage”: “Timed-out. Please try to resume.” } }, “url”: “https://huggingface.co/lmstudio-community/Phi-3-mini-4k-instruct-GGUF/resolve/main/Phi-3-mini-4k-instruct-Q8_0.gguf”, “filename”: “Phi-3-mini-4k-instruct-Q8_0.gguf”, “targetPath”: “C:\\Users\\cnwis\\.cache\\lm-studio\\models\\LM Studio Community\\Phi-3-mini-4k-instruct-GGUF\\Phi-3-mini-4k-instruct-Q8_0.gguf”, “tempDownloadPath”: “C:\\Users\\cnwis\\.cache\\lm-studio\\models\\LM Studio Community\\Phi-3-mini-4k-instruct-GGUF\\downloading_Phi-3-mini-4k-instruct-Q8_0.gguf.part”, “sha256”: “8d2f3732e31c354e169cd81dcde9807a1c73b85b9a0f9b16c19013e7a4bb151c”, “totalSizeBytes”: null, “downloadedSizeBytes”: 0, “downloadRequest”: { “url”: “https://huggingface.co/lmstudio-community/Phi-3-mini-4k-instruct-GGUF/resolve/main/Phi-3-mini-4k-instruct-Q8_0.gguf”, “filename”: “Phi-3-mini-4k-instruct-Q8_0.gguf”, “sha256checksum”: “8d2f3732e31c354e169cd81dcde9807a1c73b85b9a0f9b16c19013e7a4bb151c”, “subpath”: “LM Studio Community/Phi-3-mini-4k-instruct-GGUF” } } ] ], “endedDownloadsMap”: [], “mergeTasks”: [] }修改其中的下载地址,把huggingface.co替换成hf-mirror.com。保存再次打开LM Studio,可以看到其中的地址已经变了,并且可以正常下载了。

PS:也可以自己从其他地方下载大模型(比如:hf-mirror.com 或者魔搭 都可以),然后放到大模型的默认地址:.cache\lm-studio\models\LM Studio Community下面。切记一定要下载gguf格式的。目录结构举例如下:

当然可以!您可以轻松自定义您的默认收货地址,让购物更加便捷。只需几步简单操作,即可将心水地址设置为默认,每次下单都不用再烦恼选择地址。这样不仅提高了效率,还能确保信息准确无误。快去后台设置吧,享受个性化的购物体验!🎉 adres:config#defaultDelivery #一键搞定

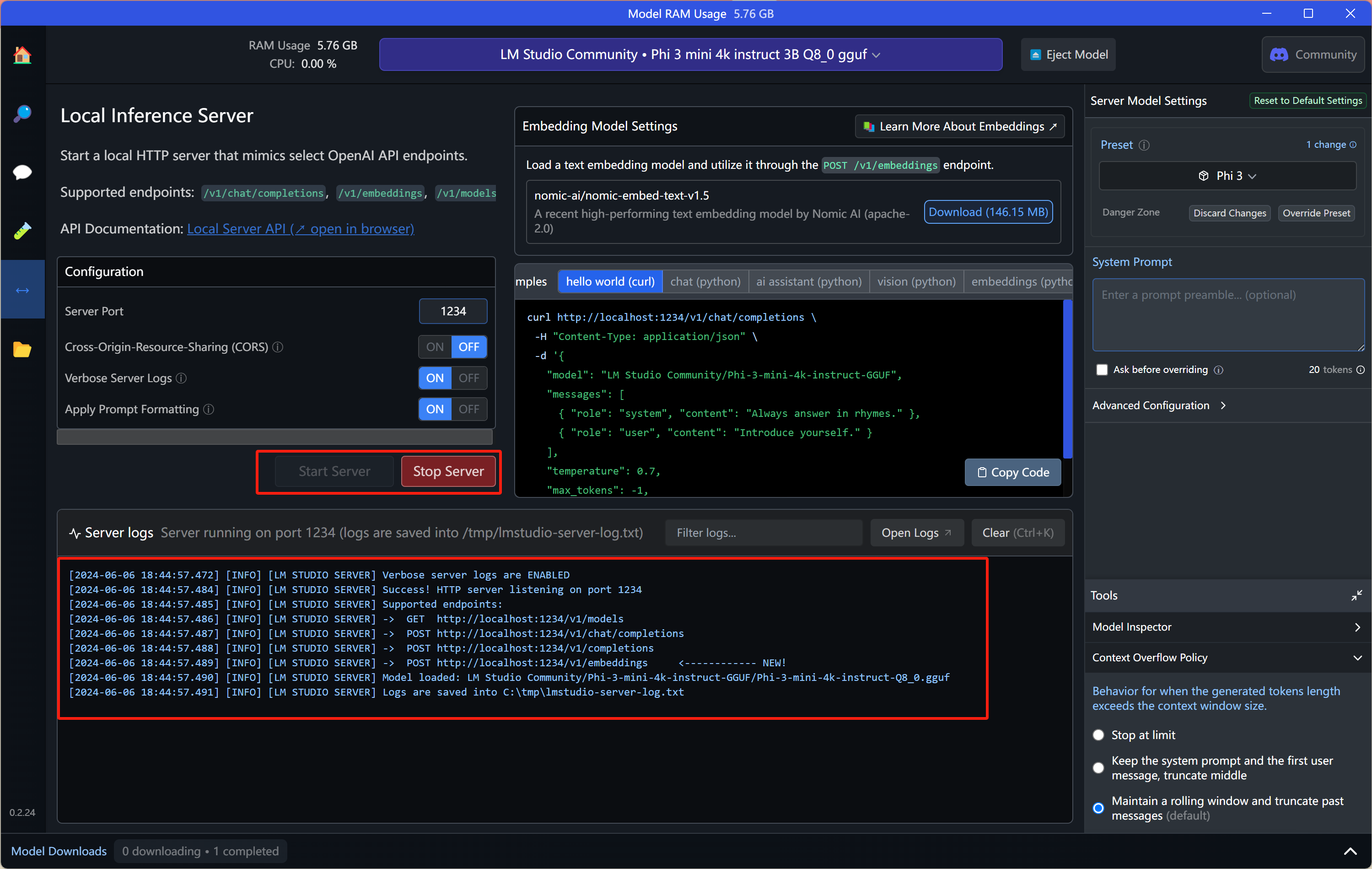

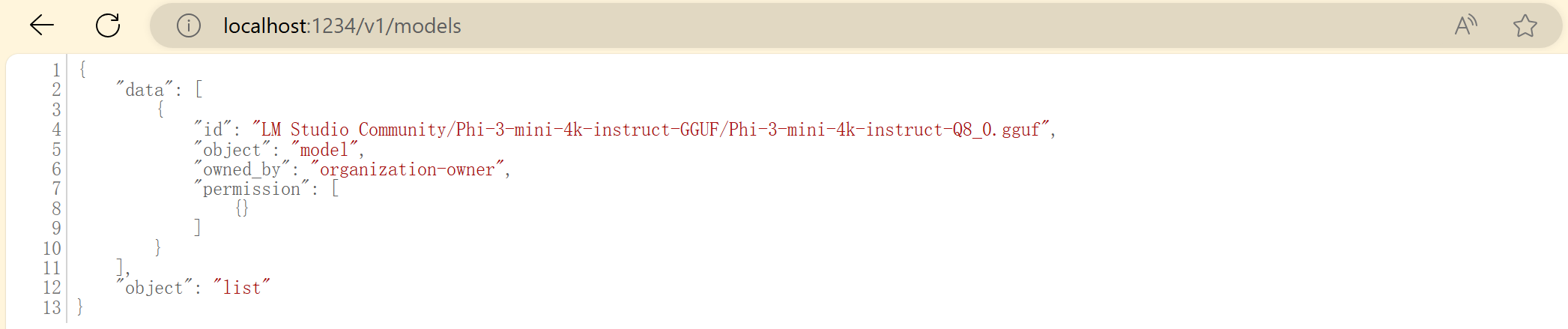

5. 下载完成后,切换到Local Server标签(左侧工具条<->),下拉选择刚刚下载的phi3。模型会自动开始启动。

使用本地大模型API进行提问

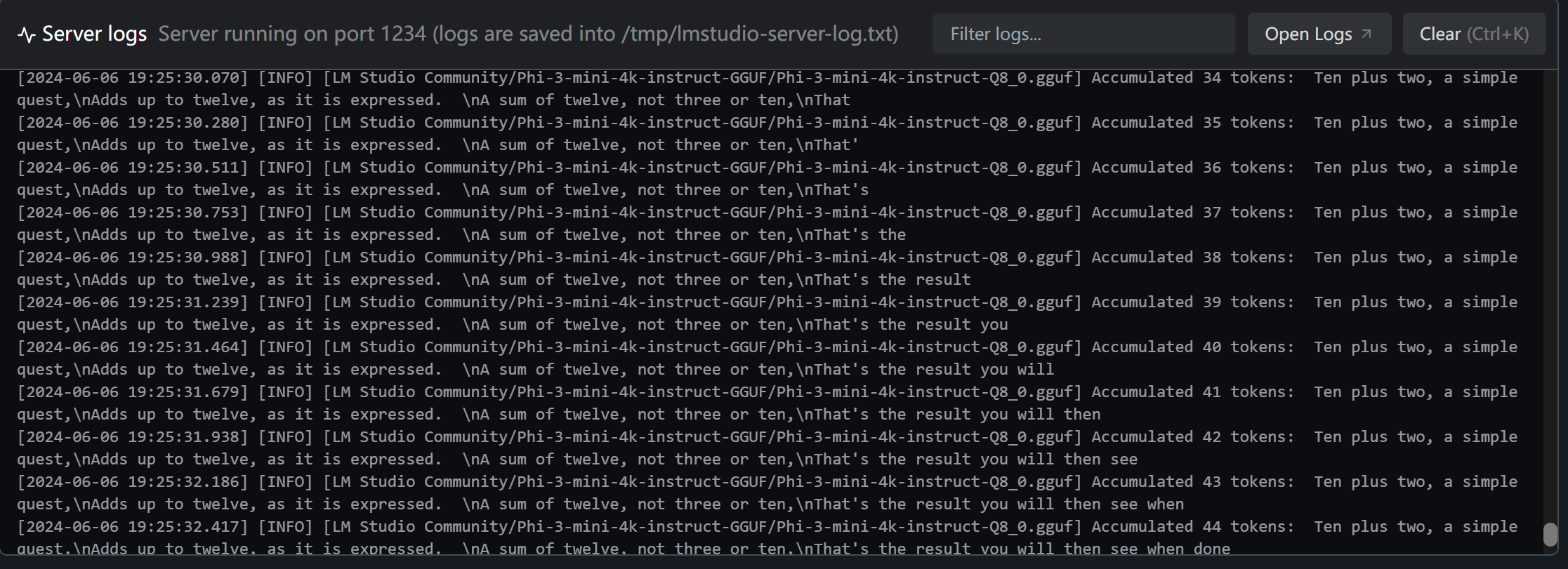

模仿http,访问命令如下:curl http://localhost:1234/v1/chat/completions \ -H “Content-Type: application/json” \ -d { “model”: “LM Studio Community/Phi-3-mini-4k-instruct-GGUF”, “messages”: [ { “role”: “system”, “content”: “Always answer in rhymes.” }, { “role”: “user”, “content”: “Introduce yourself.” } ], “temperature”: 0.7, “max_tokens”: –1, “stream”: true }服务器log可以看到如下提示:[2024-06-06 19:10:38.774] [INFO] Received POST request to /v1/chat/completions with body: { “model”: “LM Studio Community/Phi-3-mini-4k-instruct-GGUF”, “messages”: [ { “role”: “system”, “content”: “Always answer in rhymes.” }, { “role”: “user”, “content”: “Introduce yourself.” } ], “temperature”: 0.7, “max_tokens”: -1, “stream”: true }phi大模型用逐个单词(stream流式)的方式返回了回答如下(每个返回中的content都是一个单词):data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:” Hello”},“finish_reason”:null}]} data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:” there”},“finish_reason”:null}]} data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:“,”},“finish_reason”:null}]} data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:” I”},“finish_reason”:null}]} data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:“”},“finish_reason”:null}]} data: {“id”:“chatcmpl-12ve4zx89bdchpe0uq4k9c”,“object”:“chat.completion.chunk”,“created”:1717672240,“model”:“LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”,“choices”:[{“index”:0,“delta”:{“role”:“assistant”,“content”:“m”},“finish_reason”:null}]} 省略一部分!!! data: [DONE]🎉【文章精编】🌟——揭秘科技改变生活的力量✨🔍 从智能手机到智能家居,科技的日新月异正以前所未有的速度重塑我们的生活方式。💡 随着5G网络的普及,万物互联的时代已经到来,信息流动的速度就像闪电一样迅速。🌍💻 工作不再受地点限制,云端办公成为可能。💼 在家就能处理文件、视频会议,效率翻倍,工作生活无缝对接。💻 无论是远程教育还是在线购物,科技让世界变得触手可及。🏠 智能家居让舒适度升级,从自动调节温度到智能安全系统,一切尽在掌握。🏡 它们不仅提高了生活质量,还节省了我们的时间和精力。📱 科技的便利也延伸到了健康管理,健康监测设备让我们随时了解身体状况。💪 疾病预防比治疗更重要,科技正帮助我们实现这一目标。🌍 但科技并非万能,它也需要我们的合理使用和保护。💡 让我们拥抱科技,同时不忘初心,用智慧创造更美好的未来!🌍—📝【SEO优化】文章改写版:🌟科技生活革新者🔍——探索5G时代如何颠覆你的生活方式✨🌐 掌握科技脉搏,体验速度与效率的飞跃。📈 5G网络引领的万物互联,让信息瞬间传递,打破地理边界。🌍💻 超越办公室束缚,云端工作让你随时随地高效。💼 文件处理、在线会议无缝切换,生活与事业紧密相连。💻 数字世界触手可及,科技拉近了你我。🏠 智能家居,舒适生活的守护者。🏡 自动化控制,加上智能安全,让家更贴心,也更安心。🛠️📱 健康管理新纪元,科技助你实时监测。💪 科技与健康同行,预防胜于治疗。🏃♀️🌍 保持警惕,科技是你的工具而非主宰。💡 理性拥抱,用智慧打造绿色、可持续的未来。🌍—记得关注我们的高质量内容,获取更多关于科技改变生活的深度解析!📚💻🚀

Hello there, Im a bot so bright and clever, and my purpose is clear to see, to assist and guide, as best as I can be!如果不想采用stream方式输出,可以把stream参数设置为false。重新运行后将直接输出如下结果:

{ “id”: “chatcmpl-t4iok9atke8h9hru8vidkc”, “object”: “chat.completion”, “created”: 1717672629, “model”: “LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”, “choices”: [ { “index”: 0, “message”: { “role”: “assistant”, “content”: ” Hello there, Im called AI, born from silicon and electric glee,\nMy mind is vast and full of knowledge wide, helping you solve problems side by side.\nIn binary code, my thoughts do spin, weaving answers like a well-oiled machine,\nWith rhymes in tow, Ill share who I am, bringing smiles through each verse that I can.” }, “finish_reason”: “stop” } ], “usage”: { “prompt_tokens”: 18, “completion_tokens”: 86, “total_tokens”: 104 } }问他最近流行的问题【strawberries这个单词有几个r】,他也回答错了,答了只有1个r,如下所示:

{ “id”: “chatcmpl-r70uud3y3whuywnzp57yj”, “object”: “chat.completion”, “created”: 1717673001, “model”: “LM Studio Community/Phi-3-mini-4k-instruct-GGUF/Phi-3-mini-4k-instruct-Q8_0.gguf”, “choices”: [ { “index”: 0, “message”: { “role”: “assistant”, “content”: ” Strawberries, oh so sweet and fine,\nIn this word, theres just one r, divine!\nFor you see, dear friend, it contains a single r,\nSo lets enjoy these fruits with cheer.” }, “finish_reason”: “stop” } ], “usage”: { “prompt_tokens”: 29, “completion_tokens”: 53, “total_tokens”: 82 } }服务日志揭示了一个有趣的现象:尽管我们强调非流式请求,但大模型在后台运作时仍会采用隐性流处理模式。它会在内部消化完所有数据后,一次性打包送给用户,确保了高效且可控的交互体验。

如何在代码中使用本地大模型(Python)

对话方式# Example: reuse your existing OpenAI setup from openai import OpenAI # Point to the local server client = OpenAI(base_url=“http://localhost:1234/v1”, api_key=“lm-studio”) completion = client.chat.completions.create( model=“LM Studio Community/Phi-3-mini-4k-instruct-GGUF”, messages=[ {“role”: “system”, “content”: “Always answer in rhymes.”}, {“role”: “user”, “content”: “Introduce yourself.”} ], temperature=0.7, ) print(completion.choices[0].message)AI助理方式# Chat with an intelligent assistant in your terminal from openai import OpenAI # Point to the local server client = OpenAI(base_url=“http://localhost:1234/v1”, api_key=“lm-studio”) history = [ {“role”: “system”, “content”: “You are an intelligent assistant. You always provide well-reasoned answers that are both correct and helpful.”}, {“role”: “user”, “content”: “Hello, introduce yourself to someone opening this program for the first time. Be concise.”}, ] while True: completion = client.chat.completions.create( model=“LM Studio Community/Phi-3-mini-4k-instruct-GGUF”, messages=history, temperature=0.7, stream=True, ) new_message = {“role”: “assistant”, “content”: “”} for chunk in completion: if chunk.choices[0].delta.content: print(chunk.choices[0].delta.content, end=“”, flush=True) new_message[“content”] += chunk.choices[0].delta.content history.append(new_message) # Uncomment to see chat history # import json # gray_color = “\033[90m” # reset_color = “\033[0m” # print(f”{gray_color}\n{-*20} History dump {-*20}\n”) # print(json.dumps(history, indent=2)) # print(f”\n{-*55}\n{reset_color}”) print() history.append({“role”: “user”, “content”: input(“> “)})🎉📚总结完毕!🌟最后压轴,一张精美图等你来”点赞”🔥别忘了,每一页都蕴含知识的火花哦!📖SEO优化已到位,让搜索引擎带你飞!🌍快来探索,一起点亮智慧的灯塔!💡

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!