前言:本文教你在电脑和手机上安装ollama,通过ollama部署搭建本地大模型,完成本地AI Agent助理的搭建。

一、前言介绍

7月16日– H2O.AI最近开源了两个可以在智能手机设备上运行的大模型(LLM):h2o-danube3-4b-base和h2o-danube3-4b-chat。这两个模型都是在开源的[H2O LLM Studio]上进行训练和微调,其中带base后缀的为基础模型,chat后缀是针对聊天场景进行微调的模型。H2O-Danube技术对Llama2开源模型结构的调整后把参数压缩到4b,使用Mistral tokenizer技术把词汇量压缩到32,000,模型到上下文长度为8,192。

7月18日- OpenAI宣布免费对所有人开放GPT-4o mini,作为 GPT-3.5 Turbo的平替,OpenAI号称是其最具性价比的小型模型。其 API 价格每百万输入 token 仅为 15 美分,比 GPT-3.5 Turbo 便宜 60% 以上。

7月18日 -OpenAI开发min的同一天,mistral.ai联合英伟达打造的小型模型Mistral NeMo开源。参数量为 120 亿(12B),上下文窗口为 128k,在Apache 2.0许可下发布。

仅仅几天,就开源了多个大语言模型。可以看出,大模型的竞争已经进入到白日化,而轻量化、隐私保护变得尤为重要,这样它们可以在移动设备上进行私有化部署。设想一个AI助手,它能够深入分析你的各种数据,并且完全在你的设备上运行,无需将数据传输到网络中,这无疑会极大提升用户对其的信任度。相比之下,那些仅存在于企业云端的AI,尽管功能更为强大,但在安全性和可靠性方面却可能存在隐患。

那么,如何在手机上部署本地化大模型呢?本文将手把手教完成整个过程的部署,让你无时无刻的体验AI带来的超炫体验。

二、电脑部署

部署之前我们不得不说说开源大模型管理工具Ollama,Ollama几乎支持所有的开源模型,包括最新出来的mathstral模型:

Ollama开源代码如下:

https://github.com/ollama/ollamaOllama工具支持在Windows、MacOS和Linux、docker虚拟机等系统上运行,也支持Library(js/python)的方式使用,非常的强大、灵活。在windows上部署很简单。

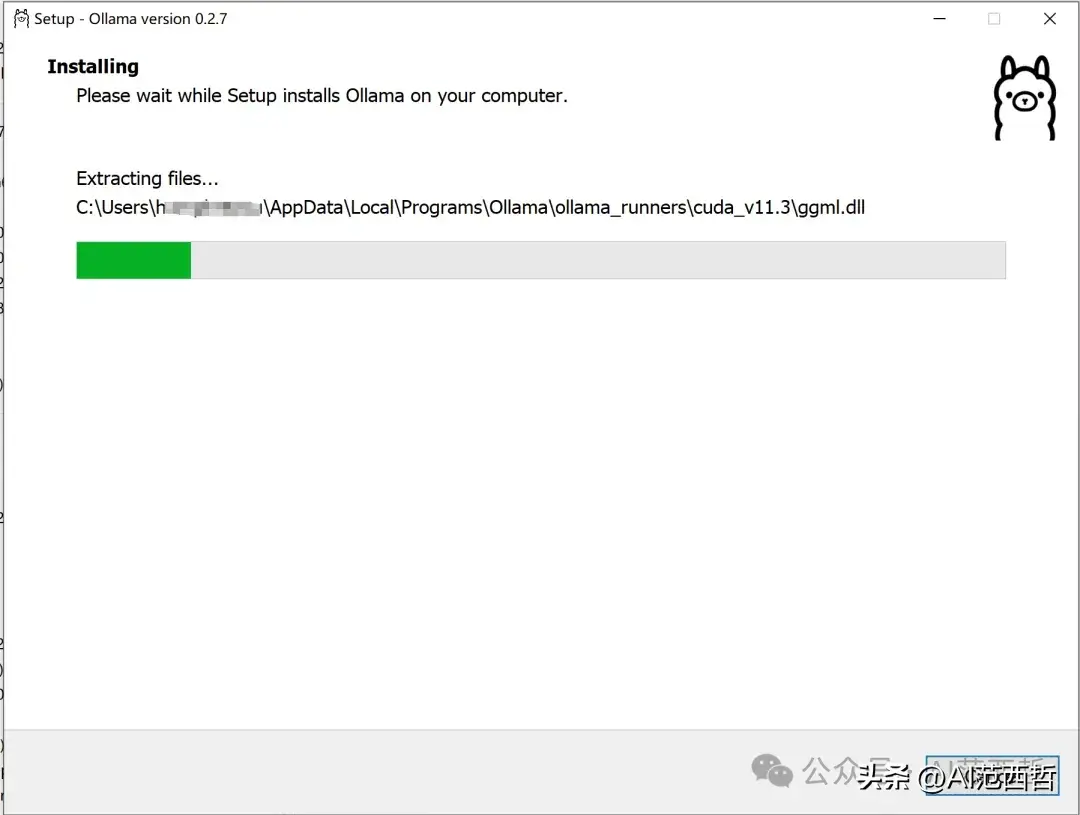

(1)下载Ollama.exe安装

https://ollama.com/download/OllamaSetup.exe

(2)设置环境变量

C:\Users\xx\AppData\Local\Programs\Ollama(3)下载大模型

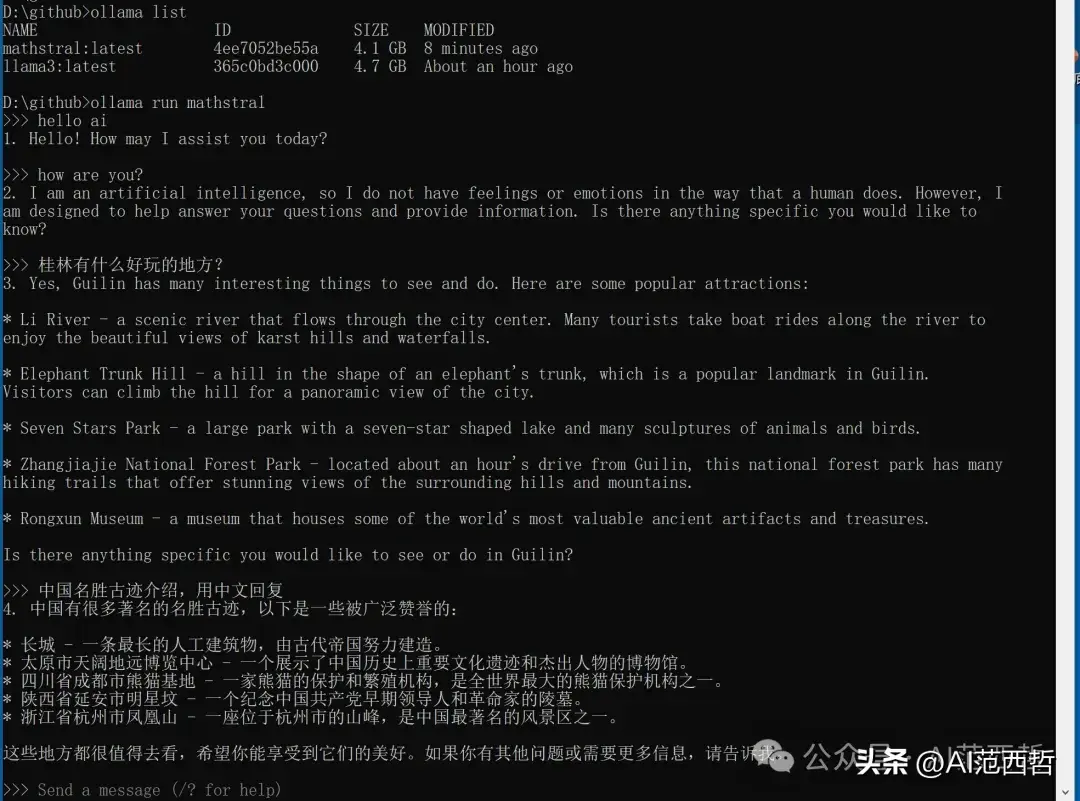

下面的命令可以下载,llama3 8B和小模型mathstral

ollama list ollama run llama3 ollama run mathstral

(4)部署AI助理:open-webui(这里推荐这个)

git clone https://github.com/open-webui/open-webui cd open-webui docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main(5)运行网页:

登录网址:http://localhost:3000/,然后选择本地模型,然后就可以对话聊天了。

三、手机部署

在Android手机上部署大模型,原理和电脑一样,不同的地方手机需要一个可以运行Linux命令的环境。所以手机部署大模型,我们用到两个app,一个可以运行Linux命令的APP为:Ternux,另一个可以运行大模型的前端应用APP:maid

手机配置情况:

项目

配置情况

手机型号

ROG phone5

Android版本

Android11

CPU

2.8GHz * 8核

Memory

12GB

存储空间

512GB

(1)下载安装开源APP:Ternux。下载地址为

https://github.com/termux/termux-app/releases安装Ternux后的界面如下

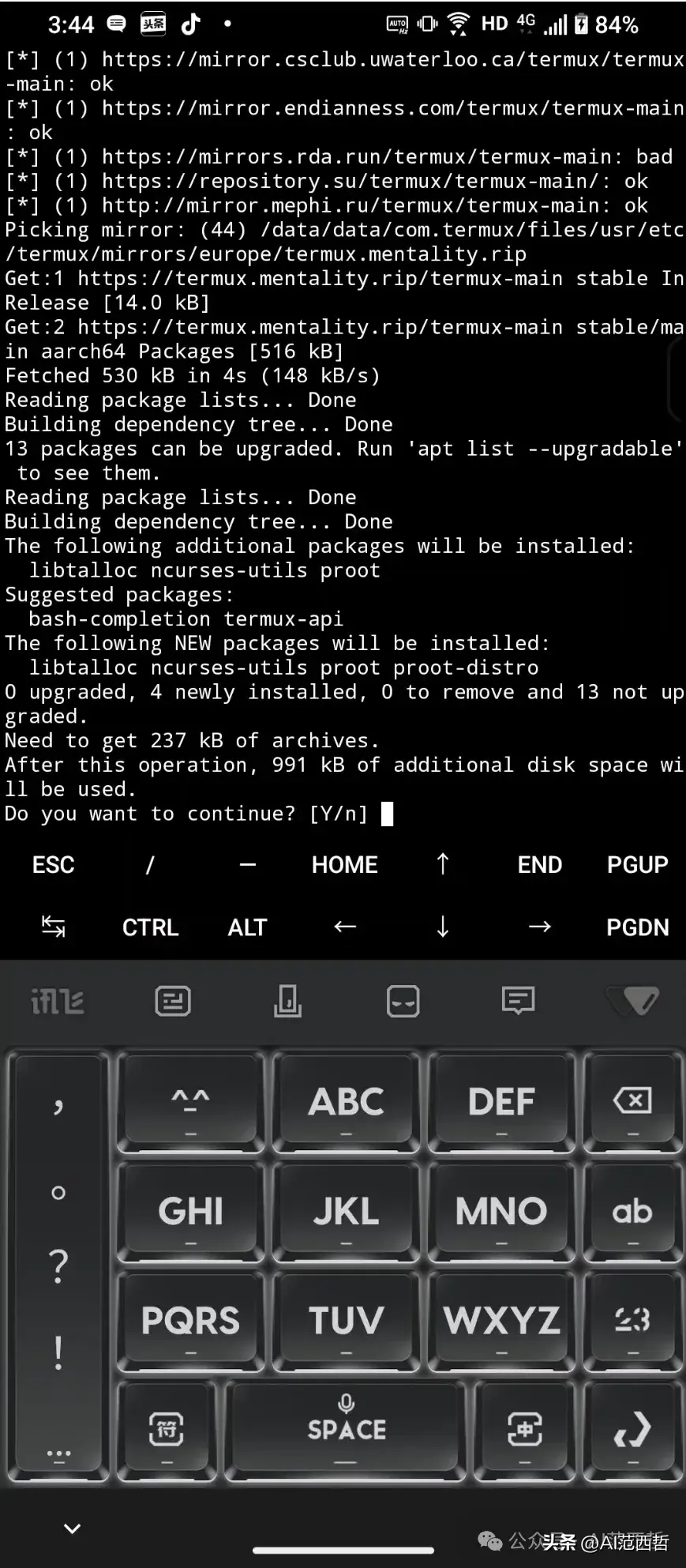

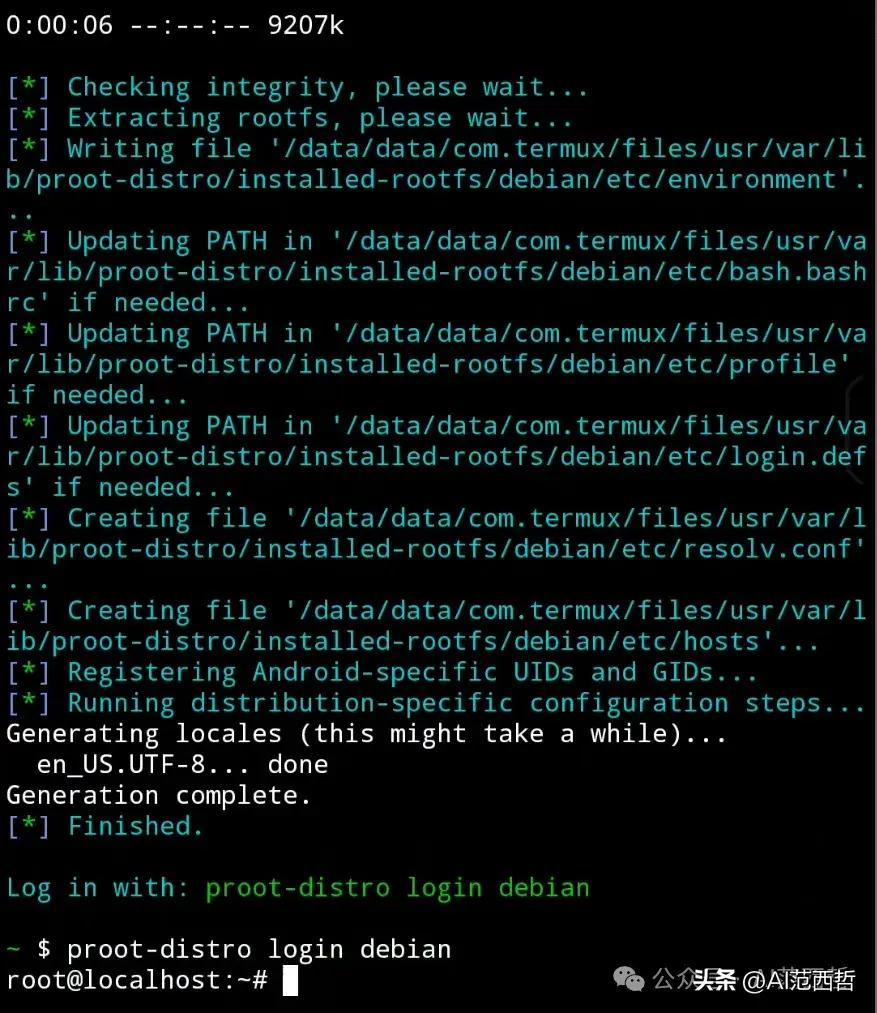

(2)安装Linux环境:在Termux中使用proot-distro安装一个Linux系统。

// first install proot-distro pkg install proot-distro //using proot-distro install debian os system proot-distro install debian // login proot-distro login debian

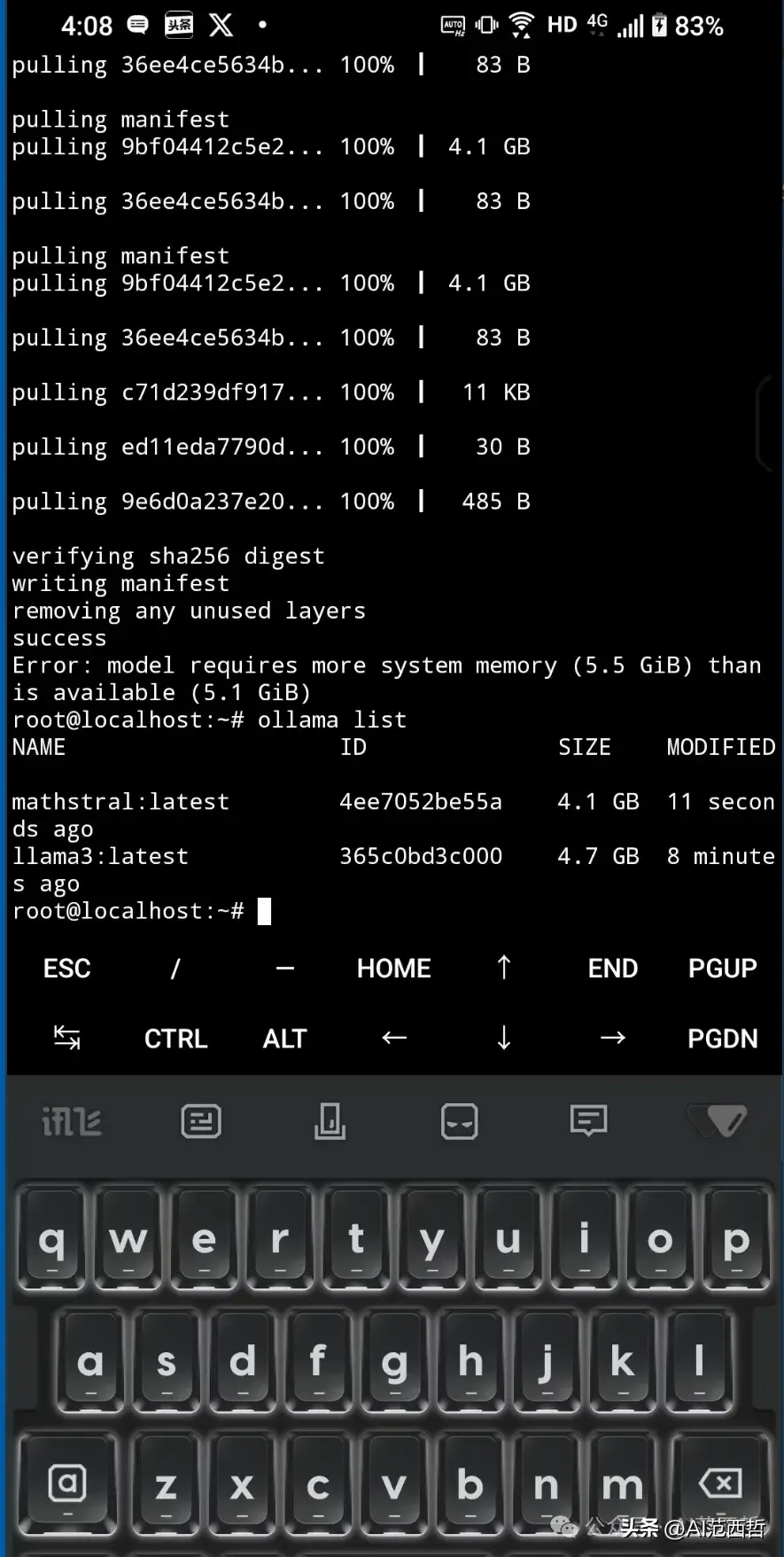

(3)安装Ollama:使用Termux安装Ollama,Linux命令如下:

curl -fsSL https://ollama.com/install.sh | sh #安装ollama ollama -v #版本情况 nohup ollama serve & #后台运行ollama服务,这样就可以通过ollama命令运行大模型 ollama run mathstral #运行大模型,如果不存在,则下载此大模型

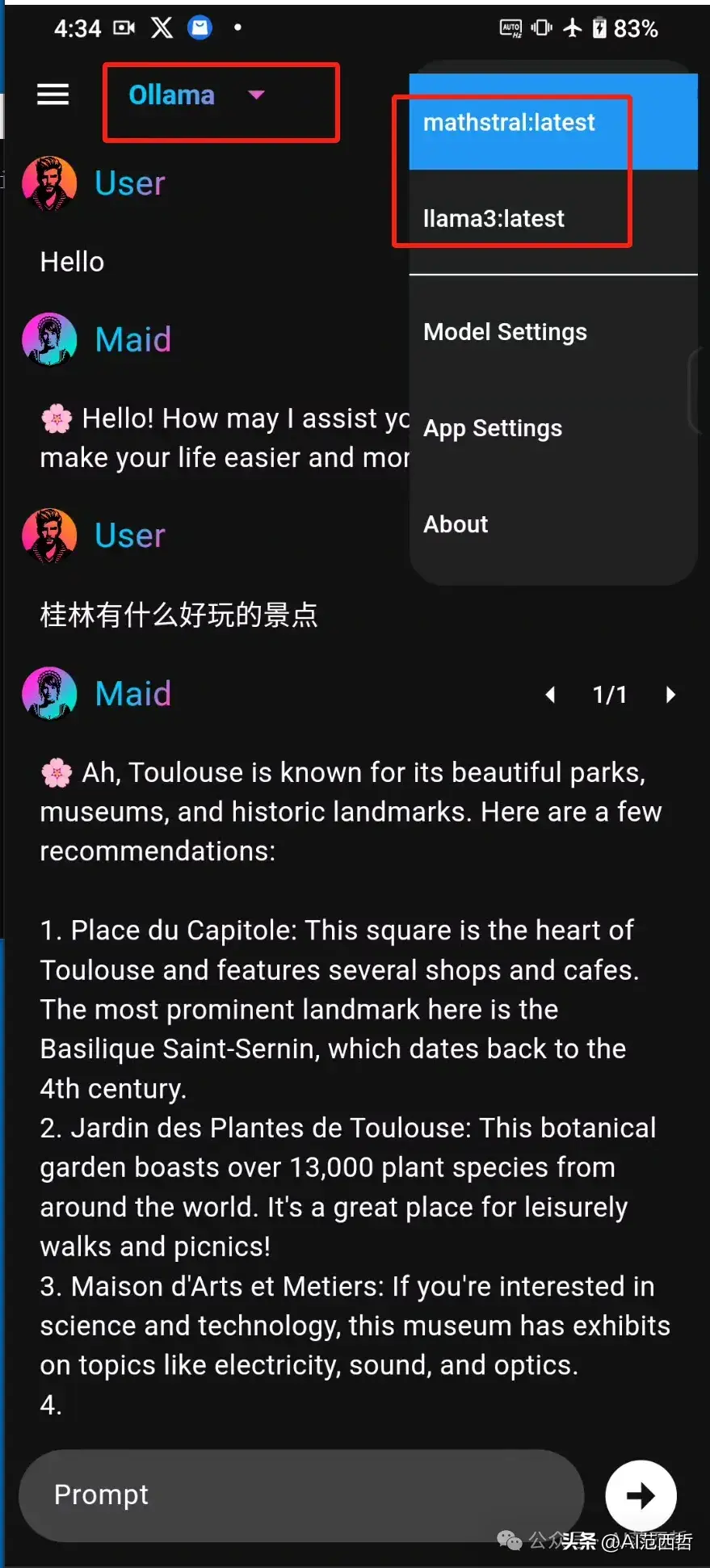

(4)安装客户端应用:maid-android-arm64-v8a.apk

https://github.com/Mobile-Artificial-Intelligence/maid

(5)配置maid选择大模型:

Ollama+mathstral:latest(模型),之后在手机离线状态下,我们依然可以和本地AI Agent进行对话了。

四、总结

本文通过在PC侧和手机侧使用Ollama部署本地化大模型,同时还搭建本地AI助理应用,来介绍了AI大模型的使用的一些基本思路方法。

优势:

(1)本文介绍的工具,均为开源工具,我们可以很方便的修改或者定制化自己的产品。

(2)通过Ollama可以很方便在手机或者PC搭建一个CS架构的AI本地化大模型,一键安装,命令简单。

(3)Ollama相当于一个大模型管理和服务工具。通过Ollama部署之后,我们可以安装不同的UI来访问本地化的AI大模型。

不足之处:

(1)在手机侧无法很好利用GPU和DSP等硬件资源,导致模型运行速度比较卡顿,体验上还有很大优化空间。

(2)maid中文prompt输入,回答输出依然是英文,中文的支持还需要定制化修改,幸亏maid为开源的软件,用户可以自己定制化自己的语言。

(3)手机侧需要通过Termux模拟工具来安装Ollama,当前还没有能直接安装在手机上的Ollama应用。

参考文章:《ollama-open-source-llms-anywhere》https://www.exxactcorp.com/blog/deep-learning/ollama-open-source-llms-anywhere

敲码不易,欢迎转发和点赞!