我越来越倾向于使用Ollama了,它的模型库上新快,界面设计非常简洁,而且支持的第三方应用也很丰富。

今天我又发现了一个非常有趣的项目仓库。

Enchanted LLM 是一个与 Ollama 兼容的 iOS/iPad应用程序,它允许用户使用 Ollama 平台来与一些私人搭建和托管的语言模型进行交流,这些模型包括 Llama2、Mistral 等。

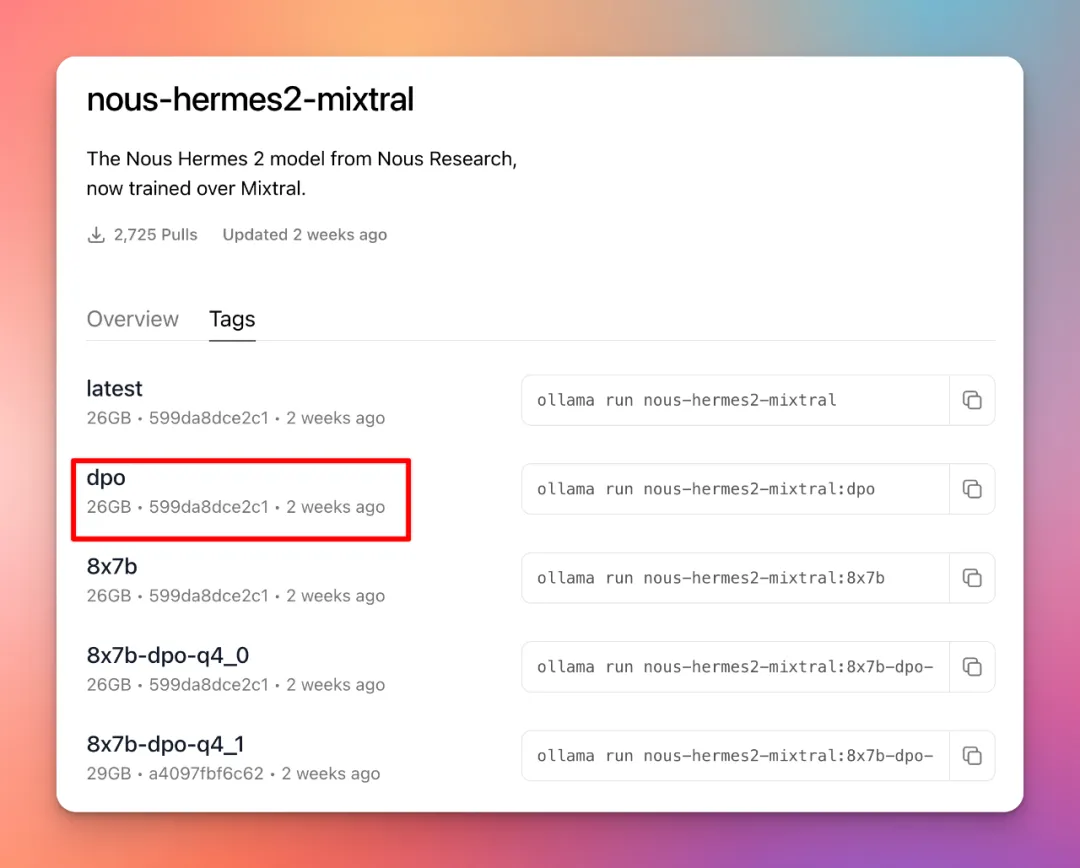

个人电脑部署主要步骤:在电脑上安装和运行Ollama服务在App Store下载Enchanted LLM应用使用ngrok、LocalTunnel等工具将Ollama的本地接口转发为公网地址在Enchanted LLM中配置转发后的公网地址通过这种方式,Enchanted LLM可以连接本地电脑上的Ollama服务。回到正题,今天主要讲Ollama的近期值得关注的更新和Ollama CLI命令。Ollama 近期值得关注的更新1. 添加了 /? 快捷帮助命令。2. 修复了GPU内存限制时运行某些模型(如llama2, mixtral, 或llama2:13b)可能出现的内存不足错误。去年12月中旬,我尝试安装 YI-6B-200K 模型时遇到了错误。今天再次尝试时,成功安装并运行。

>>> /?

Available Commands:

/setSet session variables

/show Show model information

/load

/save

Exit

/?, /help Help for a command /? shortcuts Help forkeyboard shortcuts

Use “”” to begin a multi-line message.>>> /setAvailable Commands:

/setparameter … Set a parameter

/set system

template

wordwrap Enable wordwrap

/setnowordwrap Disable wordwrap

/setformat json Enable JSON mode

/setnoformat Disable formatting

/setverbose Show LLM stats

/setquiet Disable LLM stats

>>> /show

Available Commands:

/show info Show details forthis model

/show license Show model license

/show modelfile Show Modelfile forthis model

/show parameters Show parameters forthis model

/show system Show system message

/show template Show prompt template

>>> /setparameter

Available Parameters:

/set parameter seed

parameter num_predict

parameter top_k

> Pick token based on sum of probabilities

/set parameter num_ctx

> Set creativity level

/set parameter repeat_penalty <float> How strongly to penalize repetitions

/set parameter repeat_last_n <int> Set how far back to look forrepetitions

/set parameter num_gpu

, … Set the stop parameters>>> /? shortcuts

Available keyboard shortcuts:

Ctrl + a Move to the beginning of the line (Home)

Ctrl + e Move to the end of the line (End)

Alt + b Move back (left) one word

Alt + f Move forward (right) one word

Ctrl + k Delete the sentence after the cursor

Ctrl + u Delete the sentence before the cursor

Ctrl + l Clear the screen

Ctrl + c Stop the model from responding

Ctrl + d Exit ollama (/bye)

精选历史文章,请看这里:

探索新Ollama Python库:在应用程序中集成本地LLM

实测在Mac上使用Ollama与AI对话的过程 – 模型选择、安装、集成使用记,从Mixtral8x7b到Yi-34B-Chat

Open Interpreter:自然语言界面控制计算机 | 分享使用体验

用 Poe-API-wrapper 连接 DALLE、ChatGPT,批量完成AI绘图或文字创作

LM Studio-简化安装和使用开源大模型 | OpenAI API 文字转语音本地运行程序分享