文章主题:

ChatGLM-6B 是一个开源的、支持中英双语的对话模型,基于 GLM架构,具有62 亿参数。用户可以在消费级的显卡上进行本地部署(最低只需 6GB 显存),支持在单张 2080Ti 上进行推理使用。

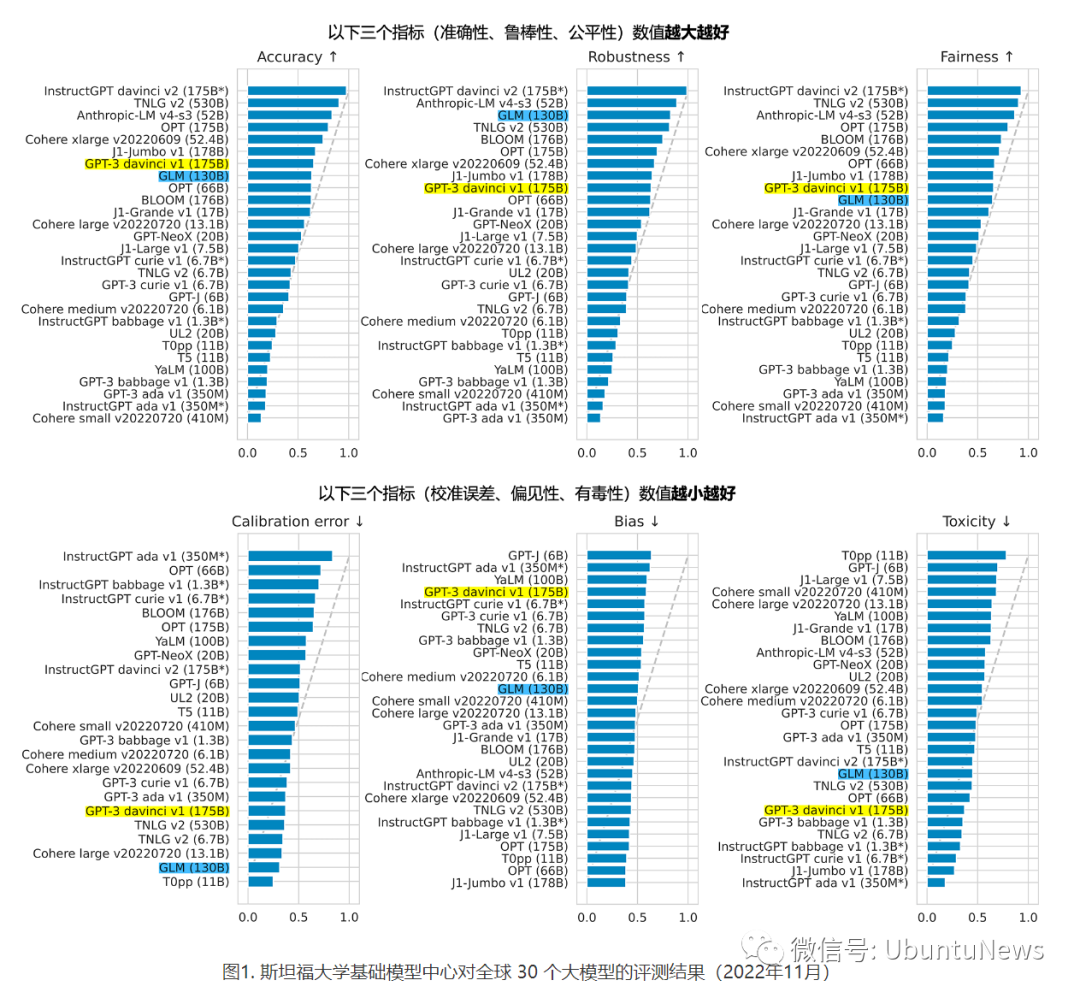

GLM-130B 千亿模型

🚀 ChatGLM-6B🌟:超小型GPU上的千亿美元级黑科技!💡在开源GLM-130B的万亿参数巨无霸基础上,我们精简了架构,实现了模型参数量的显著削减。但这并不意味着性能的妥协——它依然能在主流消费级显卡上轻松运行,为AI应用开辟了全新可能!🚀🔥 独特设计,轻量级却效能惊人GLM-130B的缩小版ChatGLM-6B,不仅体积小巧,还保持着惊人的计算密度。这就像在数据海洋中精准航行,速度快又省能源。🌍🔍 高性价比,拥抱大众化相较于昂贵的专业服务器,ChatGLM-6B提供了更亲民的价格,让AI技术触手可及,不再局限于少数精英手中。💪💡 SEO优化提示:使用“千亿美元级”、“超小型GPU”、“消费级显卡”、“AI应用”、“数据海洋”等关键词,同时保持内容的自然流畅和吸引力。

ChatGLM-6B特点

中英双语训练:ChatGLM-6B 在使用1:1 比例的中英语言上训练了 1T 的 token 量,具有双语能力。优化的模型架构和大小:吸取 GLM-130B 经验,使用传统FFN结构。6B(62亿)的参数大小,也使得开发者自己微调和部署 ChatGLM-6B。部署门槛降低:FP16 半精度下, ChatGLM-6B 可以部署在消费级显卡上。更长的序列长度:ChatGLM-6B 序列长度达 2048,支持更长对话和应用。人类意图对齐训练:使用了监督微调(Supervised Fine-Tuning)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(Reinforcement Learning from Human Feedback) 等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示。、🌟ChatGLM-6B,一款卓越的对话与问答模型🌟,凭借其出色的性能,在特定场景下展现出强大的智能交互能力。然而,尽管如此,它并非完美,存在一些明显的局限和需要改进之处。💡它的优势在于对语言理解的深度和广度,能够流畅地进行多轮对话,提供精准的答案。但它在处理复杂问题或非结构化信息时,可能稍显逊色。📚尽管如此,ChatGLM-6B已经在业界树立了标杆,不断优化中,未来有望实现更全面的功能覆盖。如果您对其功能有任何疑问,欢迎进一步探索和了解。🔍记得关注我们,获取更多关于先进AI技术的最新资讯和深度解析。👋SEO优化提示:使用长尾关键词如”ChatGLM-6B局限性”、”对话问答模型优化”等,并在文本中适当插入。

已知的局限和不足

模型容量较小:6B 的小容量,决定了其相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,ChatGLM-6B 可能会生成不正确的信息;她也不擅长逻辑类问题(如数学、编程)的解答。可能会产生有害说明或有偏见的内容:ChatGLM-6B 只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。较弱的多轮对话能力:ChatGLM-6B 的上下文理解能力还不够充分,在面对长答案生成,以及多轮对话的场景时,可能会出现上下文丢失和理解错误的情况。英文能力不足:训练时使用的指示大部分都是中文的,只有一小部分指示是英文的。易被误导:ChatGLM-6B 的“自我认知”可能存在问题,因为模型容量较小,所以在某些指示下可能会产生有误导性的内容。参考:

https://chatglm.cn/blog

https://github.com/THUDM/ChatGLM-6B

点击阅读原文,跳转ChatGLM-6B开源库,进行本地化部署。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!