文章主题:文化, 交流, 学习

“清华智谱在6月25日发布了第二代大模型ChatGLM2-6B,打榜评测效果非常好,有的效果已经超越了GPT4,非常激动的想体验下第二代大模型ChatGLM2-6B的对话能力。 ”

请关注下本公众号,感谢鼓励。

本文将从以下几个方面来介绍这次ChatGLM2-6B本地部署体验。

01

—

介绍ChatGLM2-6B

ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性:

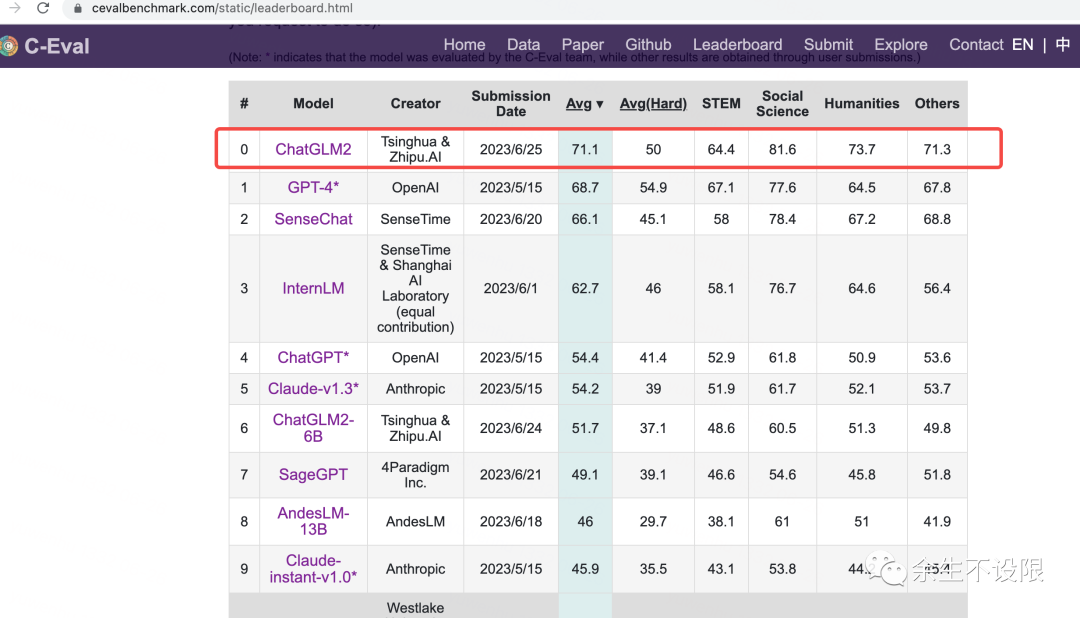

更强大的性能:相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。

更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。

更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。

Leaderboard – C-Eval 中文评测效果超越GPT4,这里点个赞!

02

—

本地部署ChatGLM2-6B

# 模型下载git clone https://huggingface.co/THUDM/chatglm2-6b# 代码下载git clone https://github.com/THUDM/ChatGLM2-6B cd ChatGLM2-6B# 安装依赖pip install -r requirements.txtpip install gradio# web交互$ python web_demo.pyLoading checkpoint shards: 100%|████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 7/7 [00:12<00:00, 1.79s/it]Running on local URL: http://127.0.0.1:7860Running on public URL: https://9a14e9cafc55c57a7e.gradio.liveThis share link expires in 72 hours. For free permanent hosting and GPU upgrades (NEW!), check out Spaces: https://huggingface.co/spaces03

—

演示和ChatGLM2-6B对话

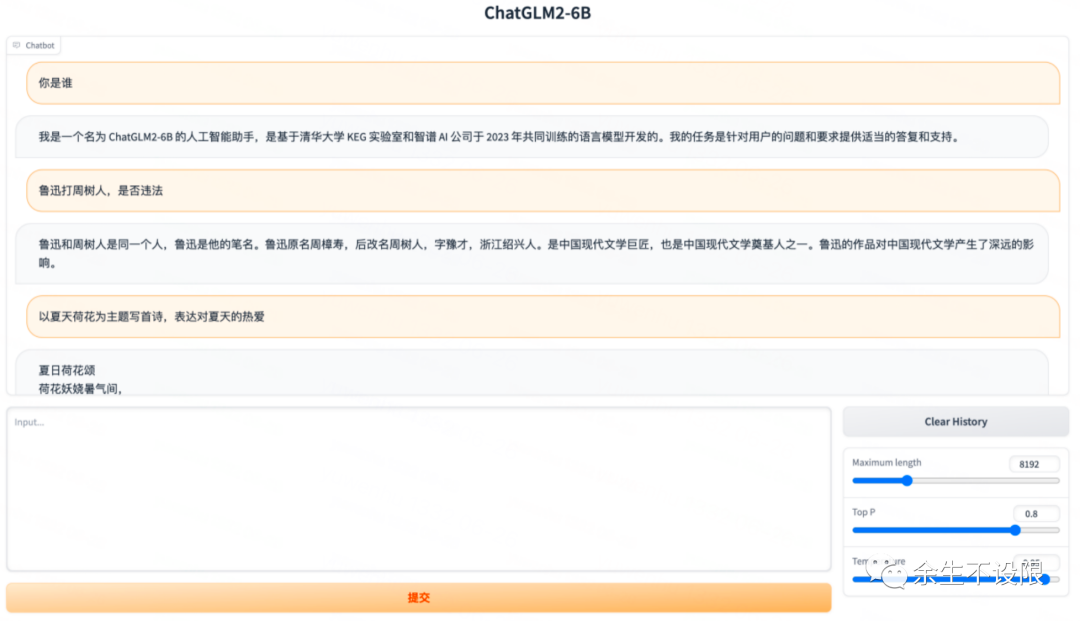

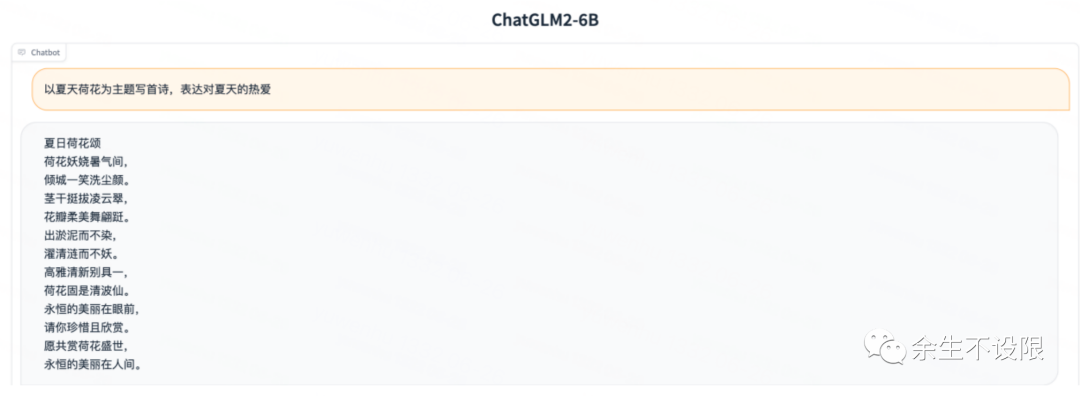

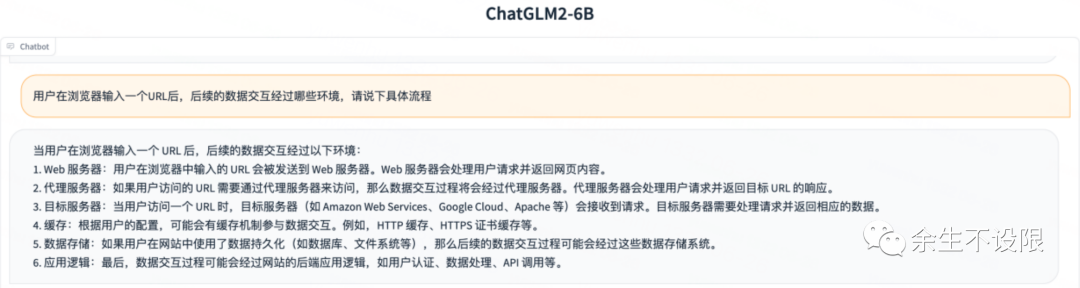

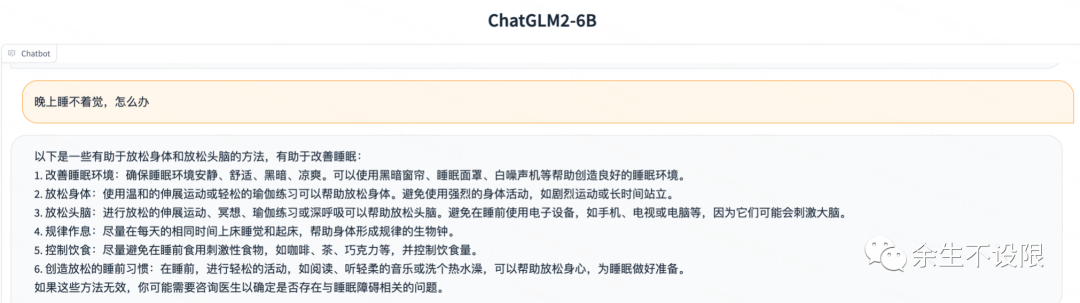

ChatGLM2-6B对话演示

04

—

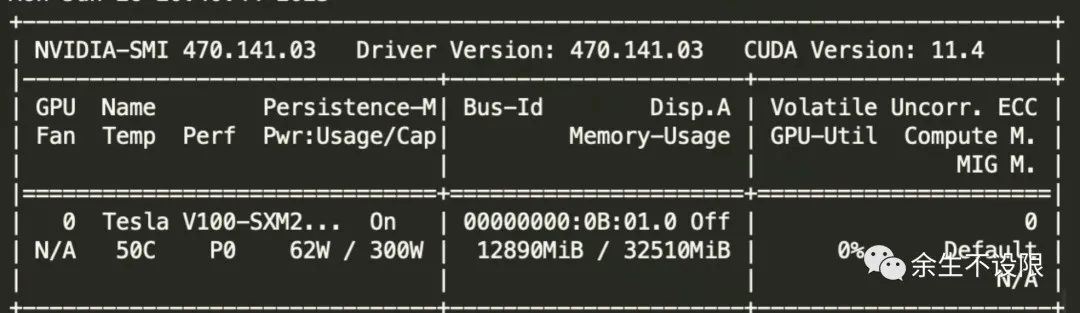

推理使用GPU资源

推理使用GPU显存12G

从对话演示的实测case来看,相比于初代模型,第二代大模型ChatGLM2-6B 多个维度的能力都取得了提升。不足之处是推理能力差点,其中2个推理问题回答不太准确,其他方面都表现挺不错的。对鲁迅和周树人的问题能给出正确的回答,已经很强大了,这点之前只有GPT4能做到。随着模型的持续迭代,效果会越来越好,非常看好ChatGLM大模型的发展。

文化, 交流, 学习

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!