文章主题:大模型, 昂贵成本, 头部公司, 小公司

openAI的chatGPT引发了一波AI浪潮,从今年2月份开始,各大公司纷纷入局AI,各种大模型如雨后春笋般推出。

但大模型昂贵的成本注定只能少数头部公司可以搞的起,那么小公司或者个人就没有机会了么?

答案是有的

那就是:ChatGLM2-6B

一个由清华大学自然语言处理实验室(THUNLP)开源的、支持中英双语的对话语言模型。

ChatGLM-6B 基于 General Language Model (GLM) 架构,具有 62 亿参数,结合模型量化技术,可以在消费级的显卡上进行本地部署。

ChatGLM2-6B可以在消费级的显卡上进行本地部署, 权重对学术研究完全开放 ,在填写问卷进行登记后亦允许免费商业使用 。开源地址:https://github.com/THUDM/ChatGLM2-6B

申请资质地址:https://chatglm.cn/

ChatGLM-6B的能力

更强大的性能:基于 ChatGLM 初代模型的开发经验,全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示。

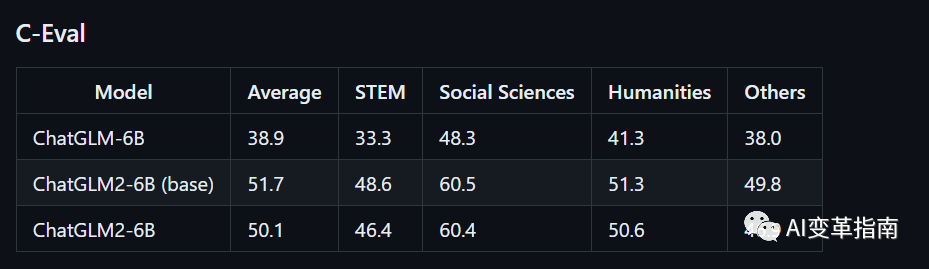

ChatGLM2-6B 相较于初代模型在多个数据集上展现了显著的性能提升,包括 MMLU(23%)、CEval(33%)、GSM8K(571%)、BBH(60%)等,这使得它在同尺寸的开源模型中具有强大的竞争力。

更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。

更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

知识推理展示:

大模型, 昂贵成本, 头部公司, 小公司

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!