文章主题:北京时间, 12, ChatGPT

北京时间12月14日凌晨,OpenAI首席执行官Sam Altman在Twitter上发布了一条消息,正式宣布重新开放ChatGPT Plus新用户的订阅服务。Altman表示,这次重新开放的主要原因是OpenAI已经成功获得了更多的GPU资源。

一个月前的某个时刻,Altman发布了一则令人关注的消息——他决定暂时停止接受ChatGPT Plus新用户的订阅(每月20美元,折合人民币约141元)。此举的原因是他认为,随着未来需求的快速增长,这种模式已无法满足我们的需求,我们希望为所有用户提供优质的服务体验。

即使对于风头正盛的 OpenAI 来说,这也不是一件易事。

在当今科技行业中,高性能图形处理器(GPU)已经成为一种战略资源,对于吸引顶尖研究人员和人才具有极大的吸引力。据公开报道透露,英伟达H100 GPU的库存量在全球排名第二的公司——Meta已将大量H100 GPU视为吸引顶级AI人才的重要手段之一。

难怪 Altman 新推文下面有网友再次感叹道:「GPU 是新的石油。」

图/ X(Twitter)

尽管算力受到一定限制,关键问题在于大型模型训练和推理过程中对英伟达高性能GPU的高度依赖。然而,英伟达的产能却受到台积电先进制程技术、封装工艺以及韩国HBM内存生产能力的制约。

说到底,还是算力不够用,「供给」赶不上「需求」。这不仅是 OpenAI 一家公司,也是整个 AI 行业所面临的危机。但现在 OpenAI 重新开放了 ChatGPT Plus 订阅,又是否意味着行业已经走出了算力短缺的危机?

并不尽然。

OpenAI 始终没有明确揭示,“找到”究竟指的是什么。是从“算力之王”英伟达手中收购更多英伟达 GPU,还是从“幕后操控者”微软那里获取支持,或者是从“备用计划”AMD处购得最新一批的 AI 芯片 Instinct MI300X?

但至少可以肯定,算力市场正在经历一轮洗牌。

英伟达的对手们

一周前,谷歌DeepMind的CEO Demis Hassabis以Gemini团队的领导身份,正式推出了一款全新的多模态大模型Gemini。这款模型不仅具备了“视觉”和“听觉”的能力,还拥有卓越的学习和推理性能。特别是Gemini Ultra版本,更是直接对接下来的GPT-4模型,行业预测其参数将超过万亿。

更耐人寻味的是,在一众基于英伟达高端 GPU 训练出的大模型中,Gemini 是唯一一个完全基于自研 AI 芯片—— TPU 训练出的万亿参数大模型。

TPU v5p 集群,图/谷歌

从单片性能来看,不管是 TPU v5e、v4 还是最新发布的 v5p 其实都远不是英伟达 H200、H100 的对手。以谷歌最新的 TPU v5p 为例,INT8 下的峰值算力仅为 918 TFLOPs,远低于上一代英伟达 H100 的 1979 TFLOPs。

但就像半导体研究机构 Semianalys 首席分析师 Dylan Patel 指出的,「对人工智能基础设施来说,系统能力比微架构更重要。」通俗来讲就是,芯片集群的算力比单块芯片的算力更重要。

在大模型训练、推理的大规模计算之中,单块芯片计算完成后需要进行通信,但受制于通信效率实际往往无法做到全部传输,这就意味着部分算力被浪费了。行业抢购英伟达 GPU 除了因为最成熟的 CUDA 生态,在于单块更强 GPU 提供的效率提升,更在于英伟达 NVLink、NVSwitch 等通信技术可以实现芯片集群的算力最大。

图/英伟达

而谷歌自研 TPU 一开始的目的就是用在全球数据中心,不可能不重视多芯片互连技术。事实上,谷歌也没有公布训练 Gemini 使用的 TPU 数目,而是强调动用了不只一个集群,甚至不只一个数据中心。

不仅如此,谷歌还宣称,包括 Salesforce 和 Lightrick 等客户已经在使用谷歌云的 TPU v5p 超级计算机来训练大模型。

谷歌之外,微软在 11 月举办的 Ignite 大会发布了自研 AI 芯片——Maia,亚马逊也于同月举办的 re:Invent 大会上推出自研 AI 芯片——AWS Trainium2。不过,目前亚马逊、微软都还没有推出基于自研 AI 芯片训练的大模型,更多还是用于大模型的推理,但也有 AI 独角兽 Anthropic 宣布了基于 Trainium2 构建模型的计划。

图/亚马逊

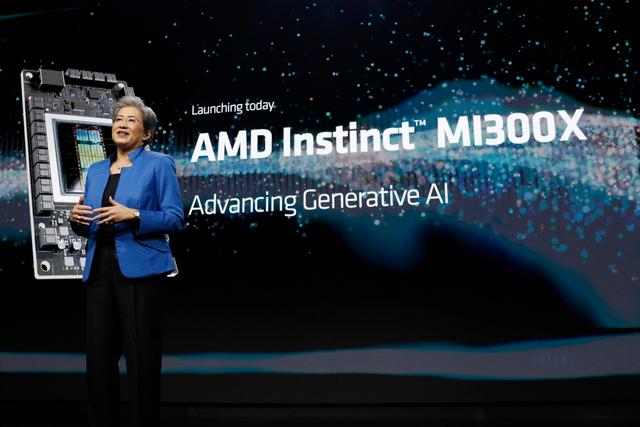

不同于云计算三巨头的竞争,英伟达老对手、芯片巨头 AMD 则在本月初的 Advancing AI 发布会上,正式推出了高端 GPU Instinct MI300X(以下简称 MI300X),谷歌、亚马逊、微软、OpenAI、甲骨文、Meta、戴尔、惠普、联想等公司纷纷为其站台。

生态上,AMD ROCm 虽然相比英伟达 CUDA 生态还有不小的差距,但 AMD 也借助整个行业加注「备胎」的风向紧赶慢赶,而且 AMD CEO 苏姿丰今年早些时候就表示,她不相信在 AI 芯片市场发展如此之快的情况下还会有什么「护城河」一说。

与此同时,微软、Meta 也都承诺购买 MI300X 用于 AI 计算需求,甲骨文甚至提前先采购了一批。另据供应链传闻,微软为此还提前一步砍掉了英伟达的部分订单。

王权没有永恒

众所周知,GPU 最初的目的就是为游戏和视频进行图像渲染。但前英伟达首席科学家戴维·柯克(David Kirk)一直有个梦想——将主要服务于图像渲染的 GPU 算力「通用化」,使之转变为通用算力中心。

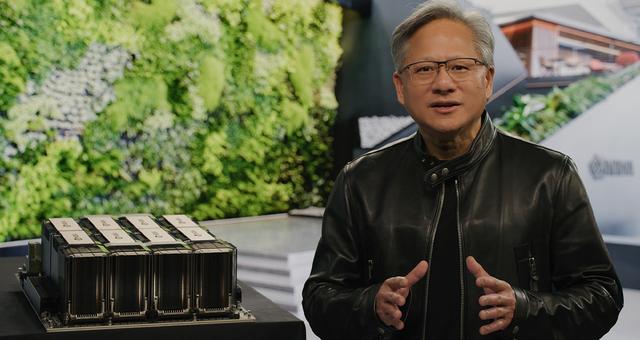

2006 年,戴维·柯克说服了英伟达创始人兼 CEO 黄仁勋推出了 CUDA(Compute Unified Device Architecture,统一计算架构)。

CUDA 的今天从来不是一蹴而就的,而是老黄连续十多年坚定的投入才实现的。从游戏、科学研究到区块链、挖矿,再到元宇宙以及今天的生成式 AI,老黄不断为 CUDA 和 GPU 算力寻找计算的出口和未来,包括在 2016 向刚刚成立的 OpenAI 捐出英伟达的第一台 AI 超级计算机——DGX-1。

黄仁勋,图/英伟达

正如多年前老黄给俄勒冈州立大学毕业生的寄语:「当有人全力以赴时,他们就能做你做不到的事情。全力以赴,不留后手。」

而很多人并不知道,早在去年 ChatGPT 推出之前,英伟达的数据中心收入就超过了游戏业务,在 ChatGPT 引爆全球科技行业之后,数据中心业务更是如同开挂般持续增长,完全压过了来自游戏玩家的收入。

但王权没有永恒。

大模型的兴起创造了海量的算力需求,英伟达的高端 GPU 几乎成为了全球科技公司的首选目标。但首先,英伟达一家公司难以满足全球市场(以中美为主)对于 AI 算力的需求;其次,不管从风险控制还是成本角度考虑,大公司在长期来看都不会接受「把鸡蛋放在一个篮子」。

最后,算力市场从来不缺竞争者,也并非赢家通吃,至少苏妈就认为,「这个市场将会有多个赢家。」

苏姿丰,图/ AMD

事实上除了英伟达,另一家芯片巨头博通也是大模型浪潮的幕后赢家。更遑论,还有以谷歌为代表的云计算巨头,正在试图垂直整合,实现从底层芯片到训练框架的自研。

同时就像前文所述,英伟达一家公司难以满足全球持续增长又不断变化的算力需求,而 AMD、谷歌、微软、亚马逊以及更多公司的加入,将会彻底改变算力的供给,提供更强大、更便宜的算力,才可能真正让大模型成为「社会基础设施」。

老黄会乐见这样的变化吗?很难讲,但至少在送出那台赠送给 OpenAI 的超级计算机时,他还在上面写了一句话:

「为了计算和人类的未来,我向你们献上世界上第一台 DGX-1。」

图/英伟达

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!