随着ChatGPT与AIGC行业的迅速发展,虚拟人、音频模仿、智能NPC等应用场景也成为了各家游戏厂商关注的焦点。而作为业内领先的研发型企业,趣加也早已布局AI赛道,通过挖掘AI技术潜力的方式进一步提升游戏研发效能,同时力争为用户提供更好服务。

围绕这一核心目标,趣加音频总监张志伟也在内部分享了名为“AI of Game Audio”的主题演讲。张老师通过深入浅出的讲解,从灵感参考、分轨辅助、语音及引擎脚本等层面,详细地介绍了当前AI技术在游戏音频创作中的应用场景。

以下为内容实录:

大家好,我是张志伟,很高兴能和大家分享有关“AI of Game Audio”这一主题的最新研究成果。

广义的来说AI早已在游戏、音乐等领域中出现与应用。今年让我们激动的是近来发展迅猛的AIGC,生成式AI。

虽然我们还没有让普通人实现从意识到实际行为的脑机接口,但是拥有神经网络、深度学习的生成式AI,已先一步变得越来越能理解人的需求,并且开始取代一些传统生产环节。

AIGC技术的掌握和操作,难度看起来比传统学习一门专业要简单。拿音乐来举例,音乐创作是一个人需要多年学习训练、实践后才能驾驭的。如今AIGC可以让文字、语音等直接生成音乐。

那么,当下火热的AI技术在游戏音频领域,能带来哪些改变和帮助呢?

游戏音频

游戏音频主要分4个部分:音乐(bgmmusic)、语音(voices)、音效(sound sfx)、声音引擎(sound engine)。从开发流程来看包含:设计、制作生产、引擎逻辑、音频QA等。在我们近期的实践中发现,AI技术可以在设计方案、制作生产等方面帮助音频设计师提速,从而赋能游戏项目。

AI音乐

传统的音乐制作流程,无论是歌曲还是配乐,基础环节包括了创作、制作两部分。展开讲分别是作曲、作词、编曲、配器、器乐录音、人声录音、混音、母带等。每个环节都需要专业人员参与,即便在数字音乐制作普及的今天,把多个环节集中于一人身上,但是这个人自身是需要多年的专业学习和项目经验的。

在传统音乐制作中,声音合成技术几十年前就已在应用。载体是合成器(乐器),核心能力就是无中生有地创造出世界上从来没有的声音。但其生产模式是需要懂得专业知识的人来操作,还是离不开人的深度参与。

音乐生成AI化的一些重要节点:

1)人工输入大量核心作曲信息

1990年已诞生了自动作曲软件Band-in-a-box,在这里我们称其为“传统自动作曲”。作曲人员输入和声、曲风等设定后产生音乐。因其自身的特点和一些限制,后来它逐渐变成了音乐专业学习中,学习曲风的辅助工具。

2)人工输入模糊作曲信息

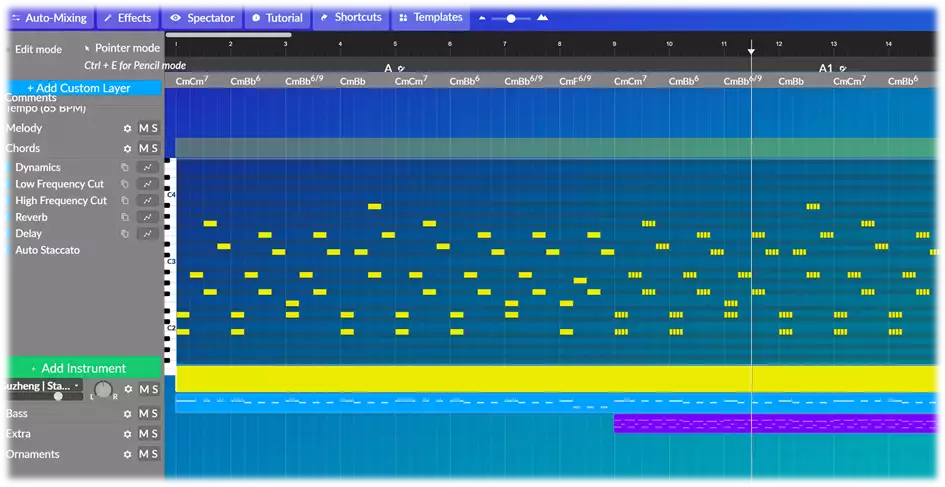

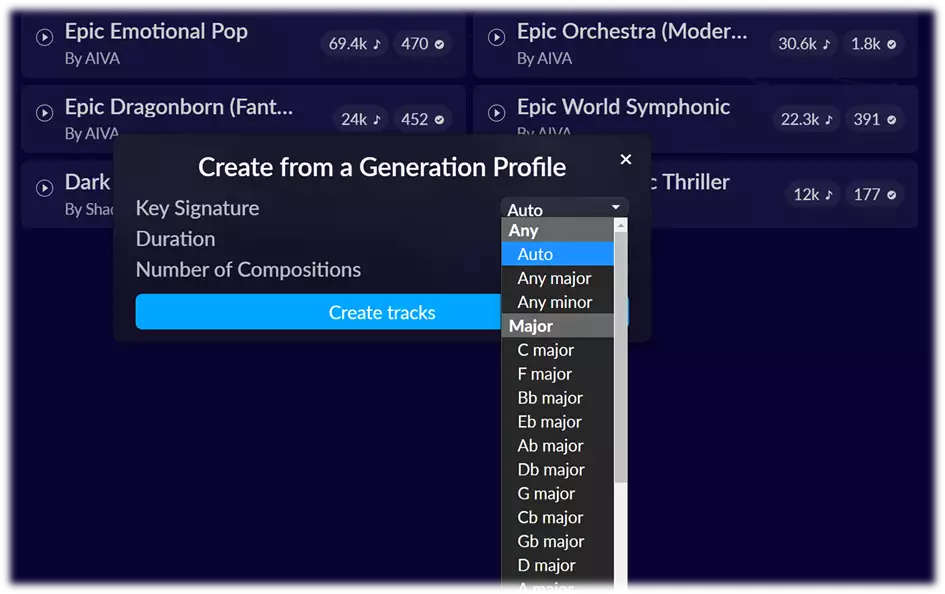

2016年出现了AIVA,我们称其为“AI自动作曲” 。操作模式是作曲人员设定曲风、调式等参数后,软件据此生成完整的音乐工程。接下来在AI软件中进行基于MIDI工程的编辑,或者输出MIDI文件和音频分轨,导入音频宿主软件进行深度的修改。这样的AI音乐技术,是能生成更多可能性的音乐,同时允许作曲者来进行反复地修改。

3)人工输入文字、图片

当下的AI音乐生成,可以不需要音乐理论知识和专业能力。输入文字、图片即可生成音乐。当然,音乐是否符合需求,取决于AI训练等很多因素。

AI音乐在游戏音频开发中能做什么呢?

第一:作曲辅助工具,快捷的提供灵感和参考。

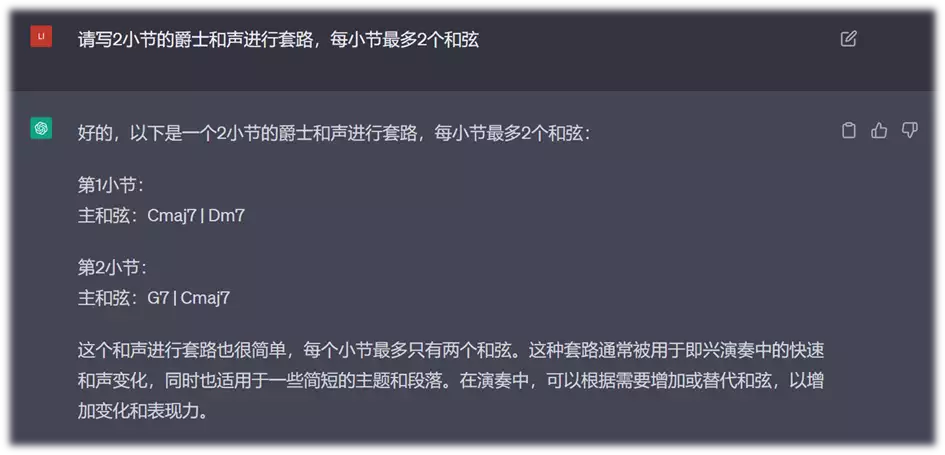

1)ChatGPT+传统自动作曲

首先我们在ChatGPT中进行提问,获得和声、调式、配器特点等信息,然后输入到传统自动作曲软件中。

在此过程中,可以结合作曲软件的优势进行更多设定。

2)AI自动作曲+专业编曲技能

前面提到AI自动作曲软件允许我们提前设定一些条件,比如曲风、调式等。由此获得一段基于目标信息的音乐,还提供MIDI工程以及分轨,让作曲者能相对快速地展开创作。

3)AIGC

生成式AI让音乐创作变得更加方便,拿MusicLM举例,它在识别文字、音频、图片后,直接生成AI理解出来的音乐。

以上方式虽不能100%获得直接应用的音乐,但是可以让更多概念、想法、意向等转变出对应的音乐灵感和创作参考。

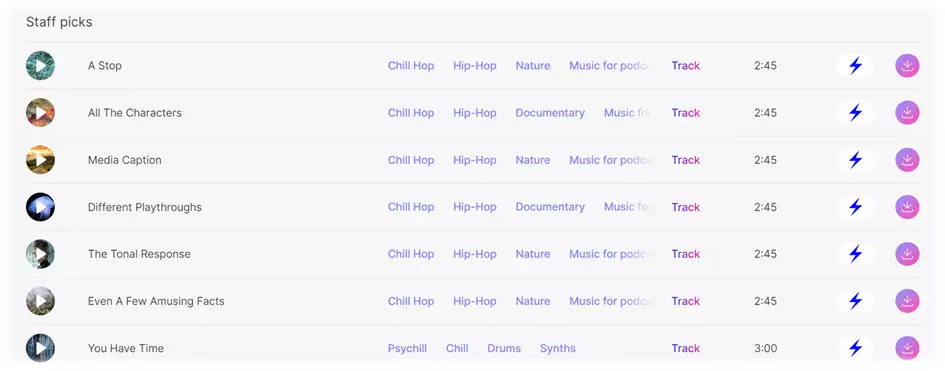

第二:产出风格化、类型化的音乐

目前主流的AI音乐软件,优势在于生成:1)大众化、风格化的音乐,比如摇滚、爵士、嘻哈、史诗交响。2)背景和氛围音乐。在游戏的场景、玩法、用研等环节都能用到。目前我们已经在游戏中利用AI音乐快速生成了帮助用研和测试游戏版本的音乐,以后有机会再进行详细分享。

AI音乐案例:

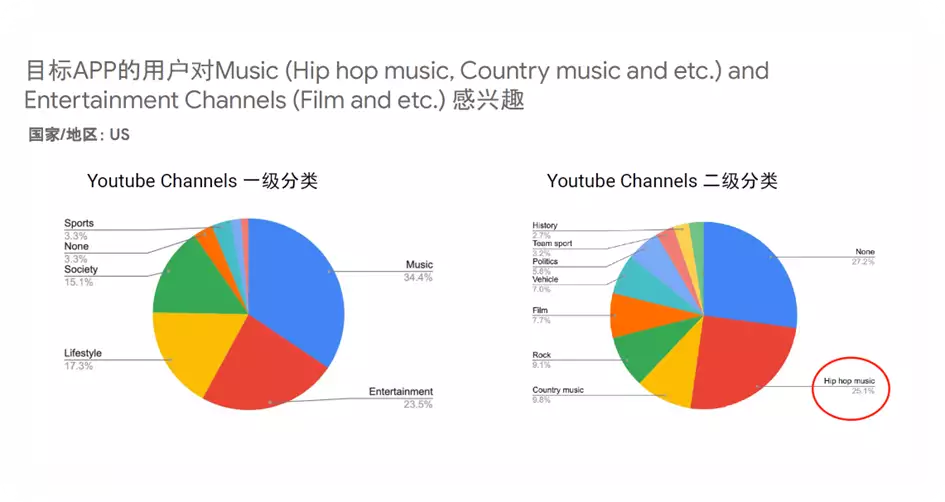

这里我举一个内部项目案例,在谷歌的调研数据中发现,基于App id全球数据,我们的用户对Hip-hop嘻哈音乐非常感兴趣。所以我们决定在这个中世纪背景的游戏中放进去一些嘻哈曲风的背景音乐,这对于音乐创作还是比较有挑战的。

按照传统的音乐制作流程,多首融合元素的背景音乐,从创作到制作完成,至少要几周时间。但是我们通过Text to Music 的AI音乐技术,2个小时生成了全部需要的音乐,并且快速地投入了游戏中。

AI语音

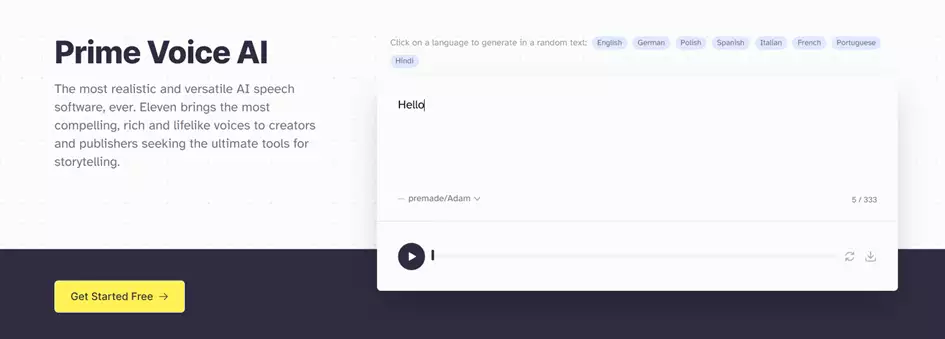

AI语音软件,在应用操作层面,主要是语音调试合成、以及语音克隆。简单来说语音调试合成是基于软件中已有模型和样本,进行一定的参数调试,最后生成音频文件。期间可以对口音、语速、断句、句间、情绪(疑问、惊讶、生气等)进行设置。语音克隆是用户自己投喂语音样本后,再进行参数调试。

AI语音软件的操作相对比较简单,如果基于已训练好的声音角色,可以快速的为游戏广告、买量视频、旁白等进行语音生产。但是想要做出符合游戏中剧情对话、角色气质的语音,所花费的人力、时间成本,可能要比传统的声音演员录制语音更多。且目前从普通人的听感来看,AI语音还是能听出不自然、生硬等问题,生成的音频文件中动态差异大、有卡顿,需要人工后期修复。

AI语音现在适合用在游戏开发中的哪些地方呢?

第一:游戏开发中版本的语音需求

如果对于语音要求不高,可以选择AI语音来快速生成。下面是一些主流的AI语音软件。

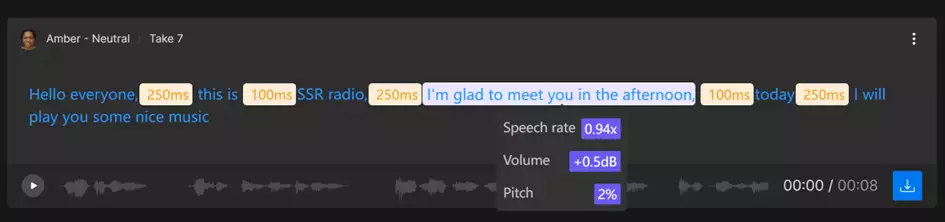

从下图可以看到,AI语音需要大量人工参与,进行逐句的调试。

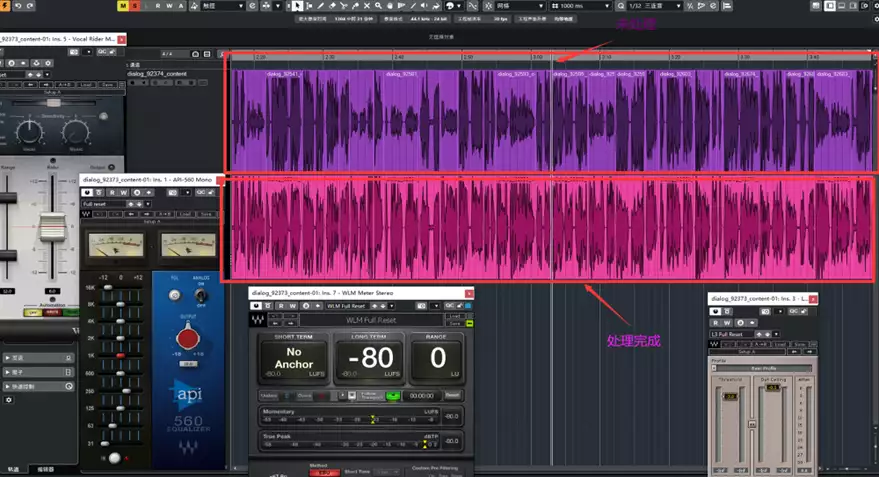

生成的AI语音音频文件,再进行人工后期处理,使其达到游戏中播放语音的正常效果。

第二:题材优势的需求,比如机器人、科幻题材。

AI语音在科幻题材以及一些需要想象力的需求中,有比较大的优势。

趣加的线上项目和在研项目,包括中世纪、魔幻、生存等不同题材都用到了AI语音的技术。

以下是我们用AI语音制作的一个案例:

创造出有个性和科幻感的机器人语音,在传统语音制作流程中,是需要配音演员到位的表演以及后期音频技术一起努力才能做出的。在上面的案例中,我们使用Text to Voices 的AI语音技术,生成基础语音样本,又通过逐字逐句地调试。获得了一套贴近游戏设定,让人满意的语音文件。

总结一下目前的AI语音在游戏中应用的优势和不足

优点:不需要录音,可反复修改。

不足:需要人工调试,音色不够丰富。

AI工具

在音频制作方面,我们看到更多的是出现了一些AI工具。

比如混音、母带的AI工具,LANDR、OZONE等。

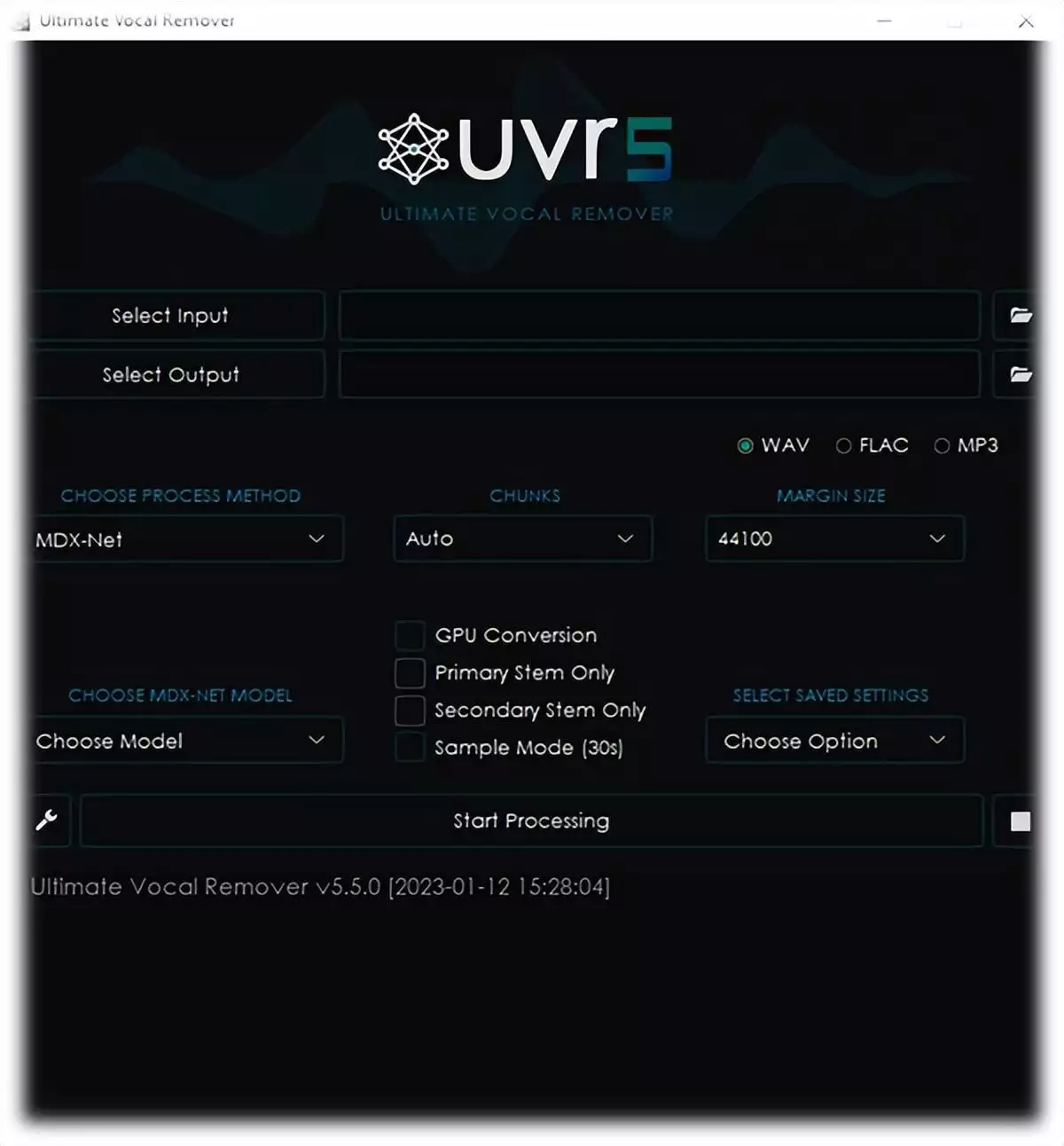

还有可以分离音乐中人声和器乐的技术,比如:UVR5。

AI与声音引擎

在声音引擎领域,AI是否也有介入呢?比如Wwise和CRI-ADX等引擎。近期对声音引擎厂商进行了咨询,得到的回复是暂时并未将AI应用在产品中。

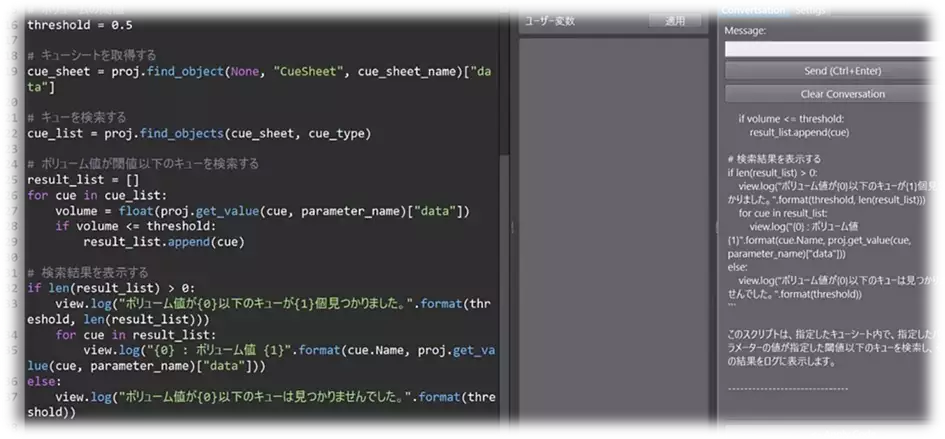

但是在翻阅官方博客时,看到了一些探索行为。比如CRI使用AI来写Robot脚本。其文章题目是:【ChatGPT x CRI Atom Craft】让AI来写Robot脚本!

总结

AI技术已经出现在游戏音频开发的很多环节,是有力的辅助工具。虽然不能做到“一键生成很多剧情对话语音”这类目标,但是作为创作和制作的助手,未来是可期的。也许随着技术快速更新,AI与游戏音频的结合能有更大的想象空间。