文章主题:

一、为什么要在本地部署大模型而不是都使用在线服务?

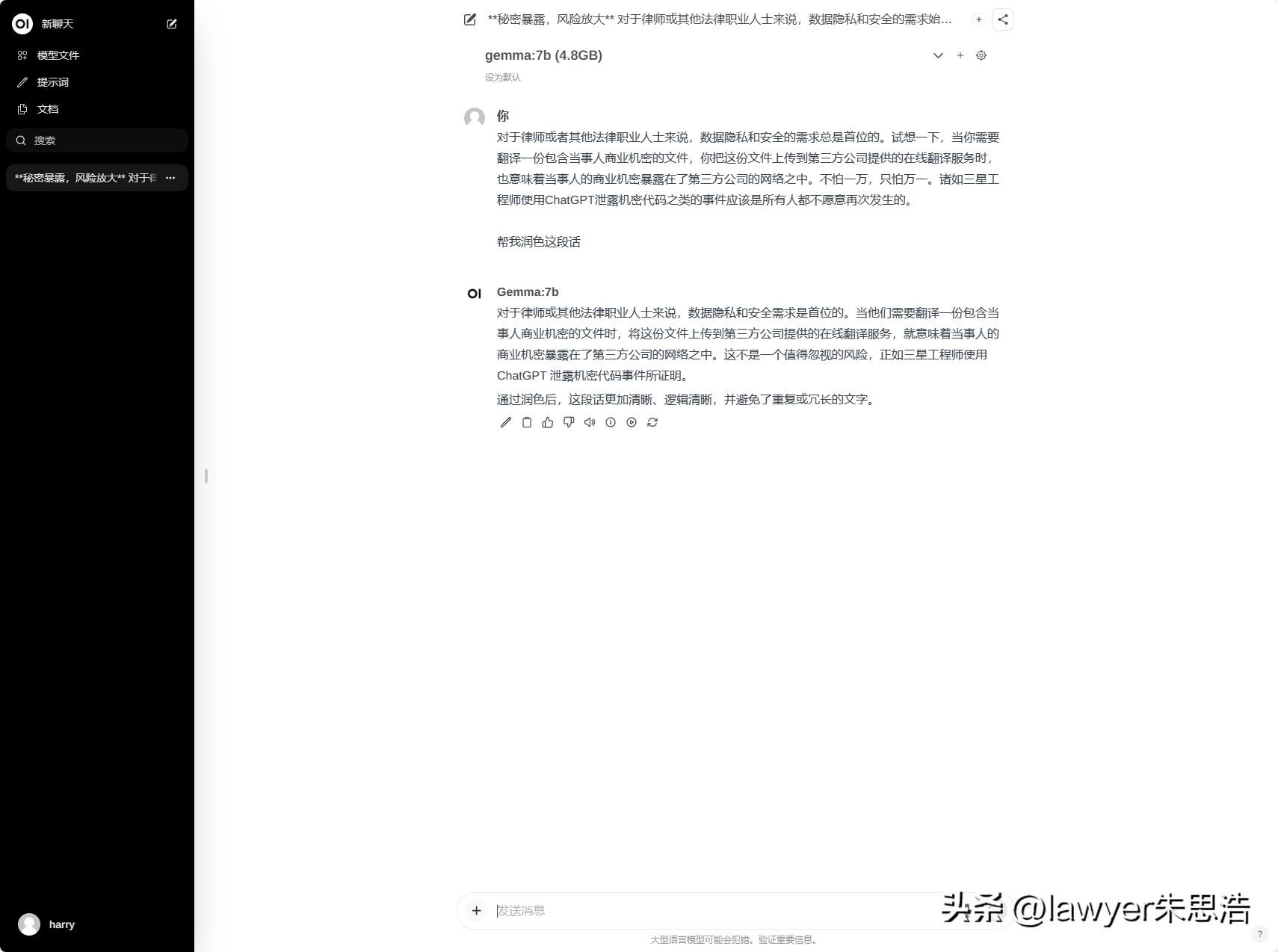

数据隐私和安全。律师和法律专业人士深知数据隐私与安全的重要性,他们面对涉及商业机密文件的翻译任务时,每一步都需谨慎。将这样的敏感材料交给在线翻译平台,无疑将这些核心信息置于潜在风险之中——第三方公司的网络就像一道无形的屏障,可能随时威胁到保密性。正如三星工程师因误用ChatGPT导致机密代码泄露的教训所警示,数据安全问题不容小觑。

无网络依赖。🌟无论身处何方,网络稳定性是关键🌟。对于依赖国外大模型的我们,网络延迟可能成为一道阻碍。相比之下,本地部署的模型就像随身携带的智囊团,无需联网也能高效运转。在网络环境受限时,如高铁或飞行中的忙碌工作中,它能轻松助你完成任务,让你的工作效率不受影响。🌍💪

自己可控。通过本地部署,无论是对历史数据的管理还是运行环境的配置,都完全由自己掌控,从而避免了因第三方服务提供商的政策变动、经营异常或暂停服务等外部因素带来的影响。

免费自己本地部署开源大模型,除了需要一台硬件配置还可以的电脑之外,不需要其他成本。而如果使用第三方公司提供的在线服务,价格往往不便宜。

二、概念介绍

(一)什么是Ollama?

简单来说,Ollama是一个开源的框架,它允许用户在本地环境中轻松设置和运行大型语言模型,如Llama 2、Gemma等,并提供自定义模型创建和多平台支持。

Ollama的主要特点包括其轻量级、可扩展性,以及对初学者或非技术人员的友好设计。它提供了创建定制语言模型和运行多种应用的能力,如文本生成、语言翻译和创意写作等。

(二)什么是Open WebUI?

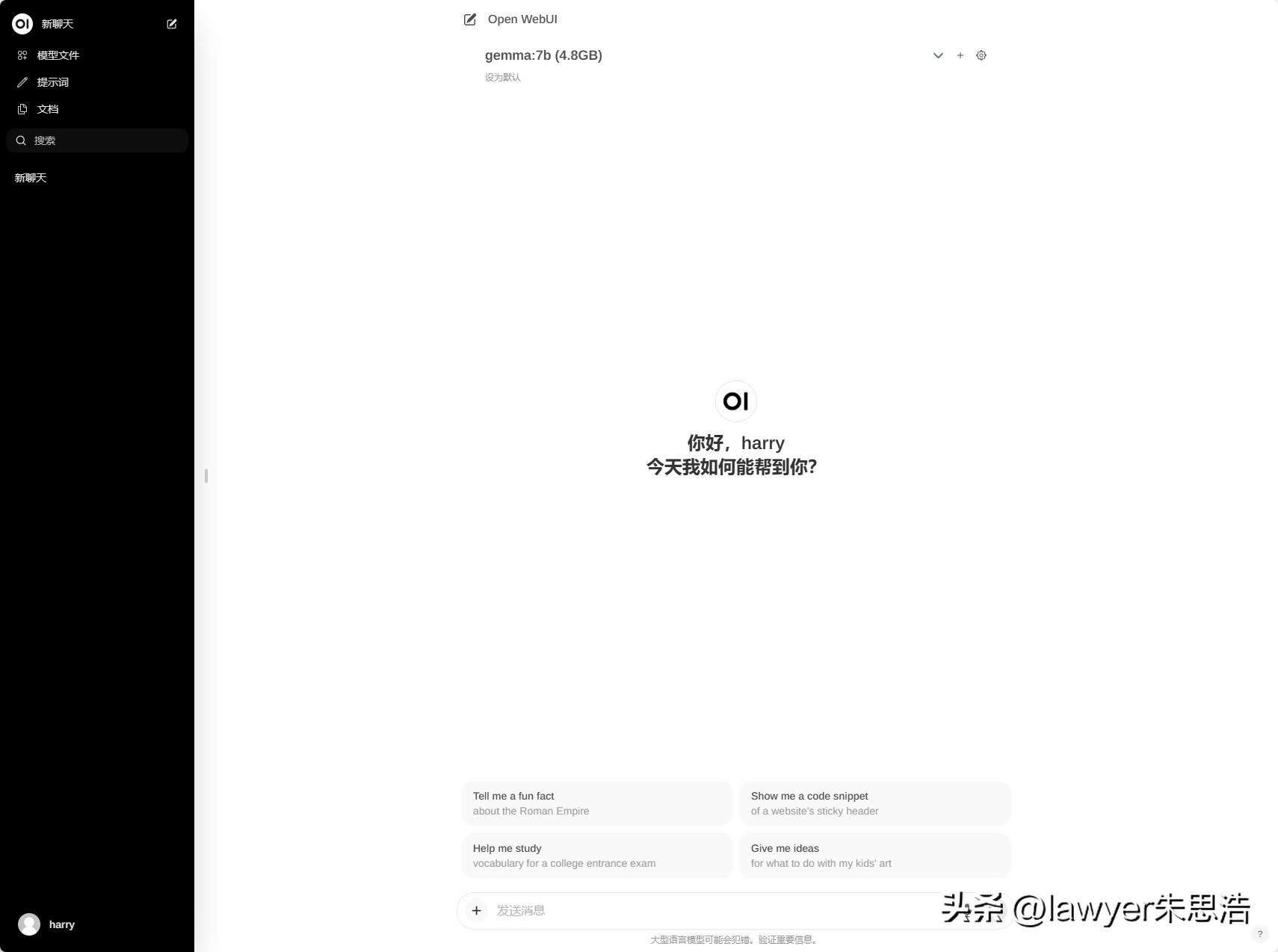

Open WebUI是一个为大型语言模型(LLMs)设计的用户友好型Web界面,旨在提供直观的聊天界面和响应式设计。它支持Ollama和兼容OpenAI的API运行程序,安装好Open WebUI就可以更方便地调用在Ollama中部署本地大模型,进行对话、图像识别等等工作。

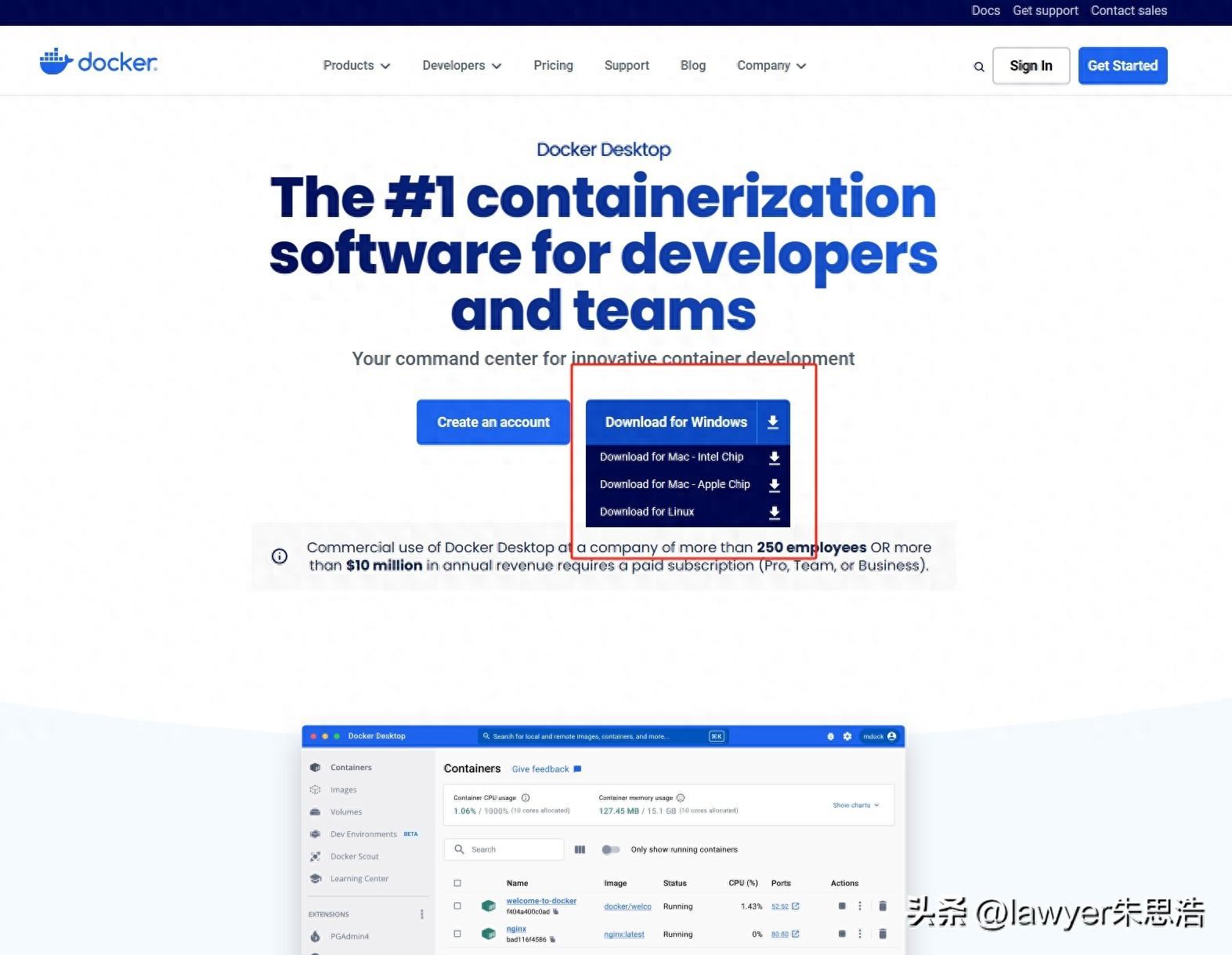

(三)什么是docker?

Docker是一个开源的容器化平台,通过将应用程序及其依赖打包到容器中来实现应用的快速部署和可移植性。安装好docker就可以更方便的部署Open WebUI等项目。

(四)什么是openai-translator?

OpenAI Translator是一个功能丰富的翻译和语言处理工具,适合需要进行跨语言沟通、学习语言、提升文本质量的用户。它可以调用Ollama中部署本地大模型进行文本翻译、文章润色、总结、代码解释等工作。

三、准备工作

提前下载好需要的软件:

dockerDocker Desktop

https://ollama.com/download

https://github.com/openai-translator/openai-translator/releases/tag/v0.3.33

四、操作步骤

(一)安装Ollama:

首先,双击下载好的OllamaSetup.exe文件,按照提示完成安装。安装完成打开后,会出现ollama的图标。

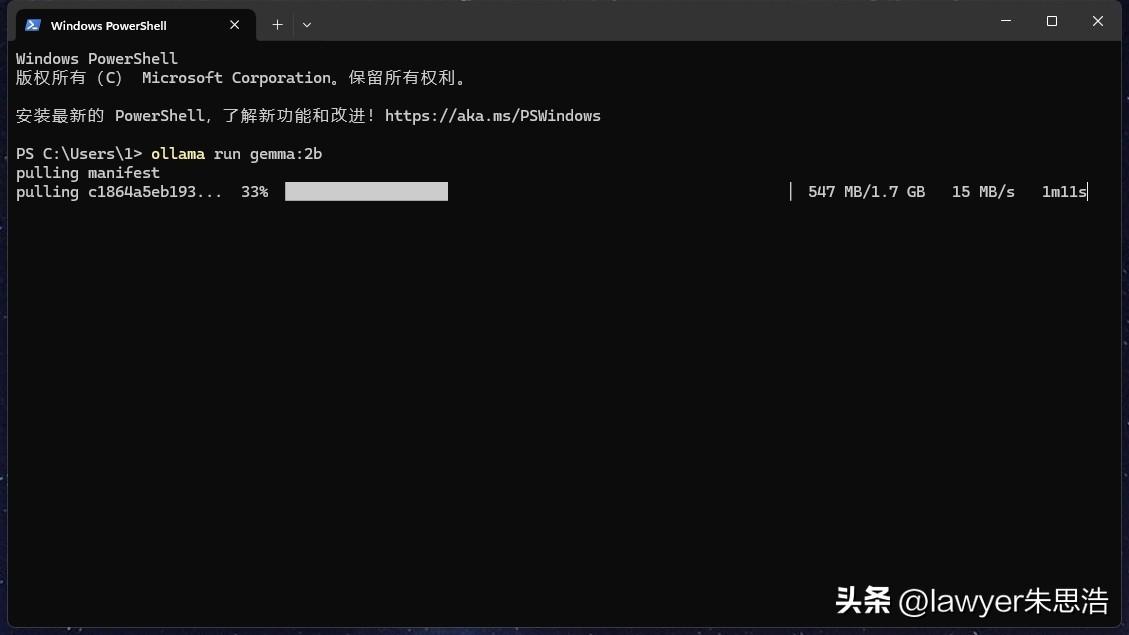

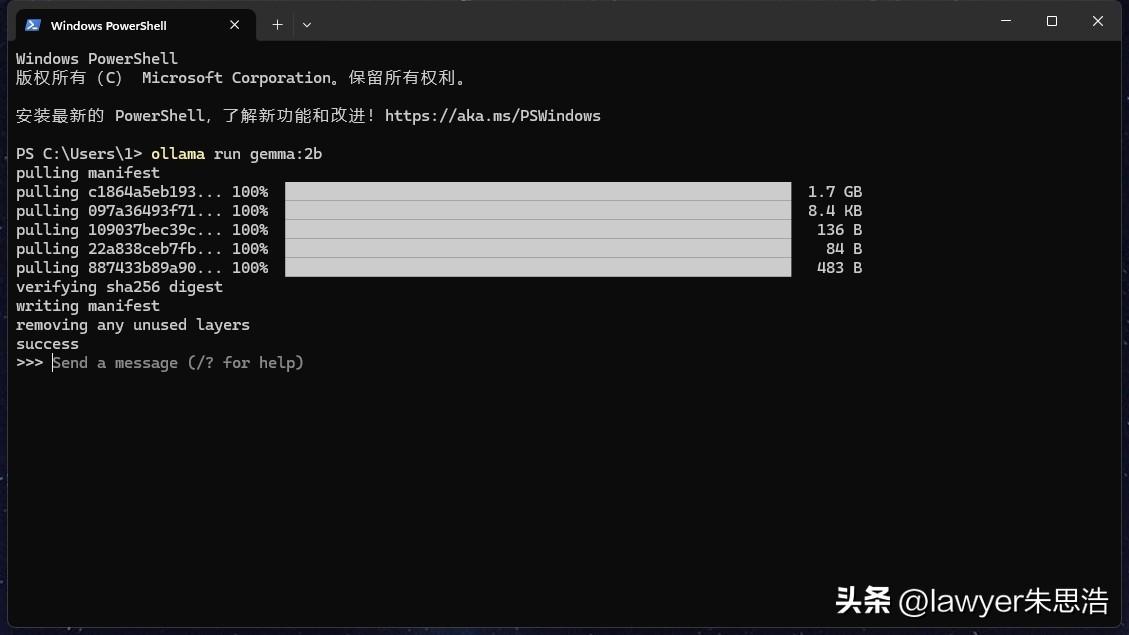

(二)下载大模型:

(根据自己电脑的硬件配置选择,推荐google最新的开源大模型Gemma,如果内存是16g及以下的可以选择gemma:2b,内存在32g及以上的可以选择gemma:7b)

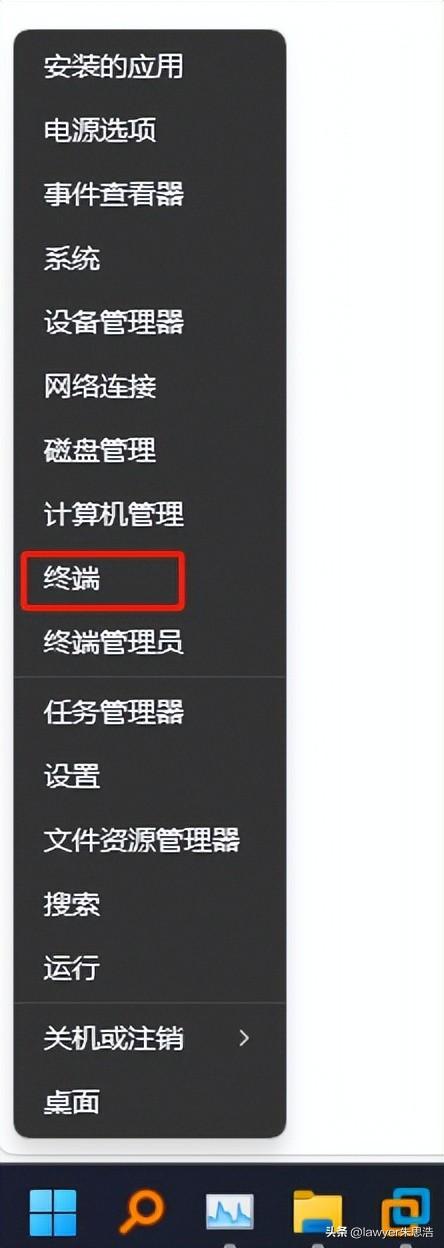

右键windows开始按钮,选择“终端”;(如果是mac电脑,直接点击“终端”即可)

备注:

我们也可以去Ollama网站选择其他想要部署的大模型。模型可根据自己电脑的硬件配置选择,推荐google最新的开源模型Gemma,如果内存是16g及以下的可以选择gemma:2b,内存在32g及以上的可以选择gemma:7b。配置更好的,可以选择参数更大的。(其他模型下载地址:

https://ollama.com/library)

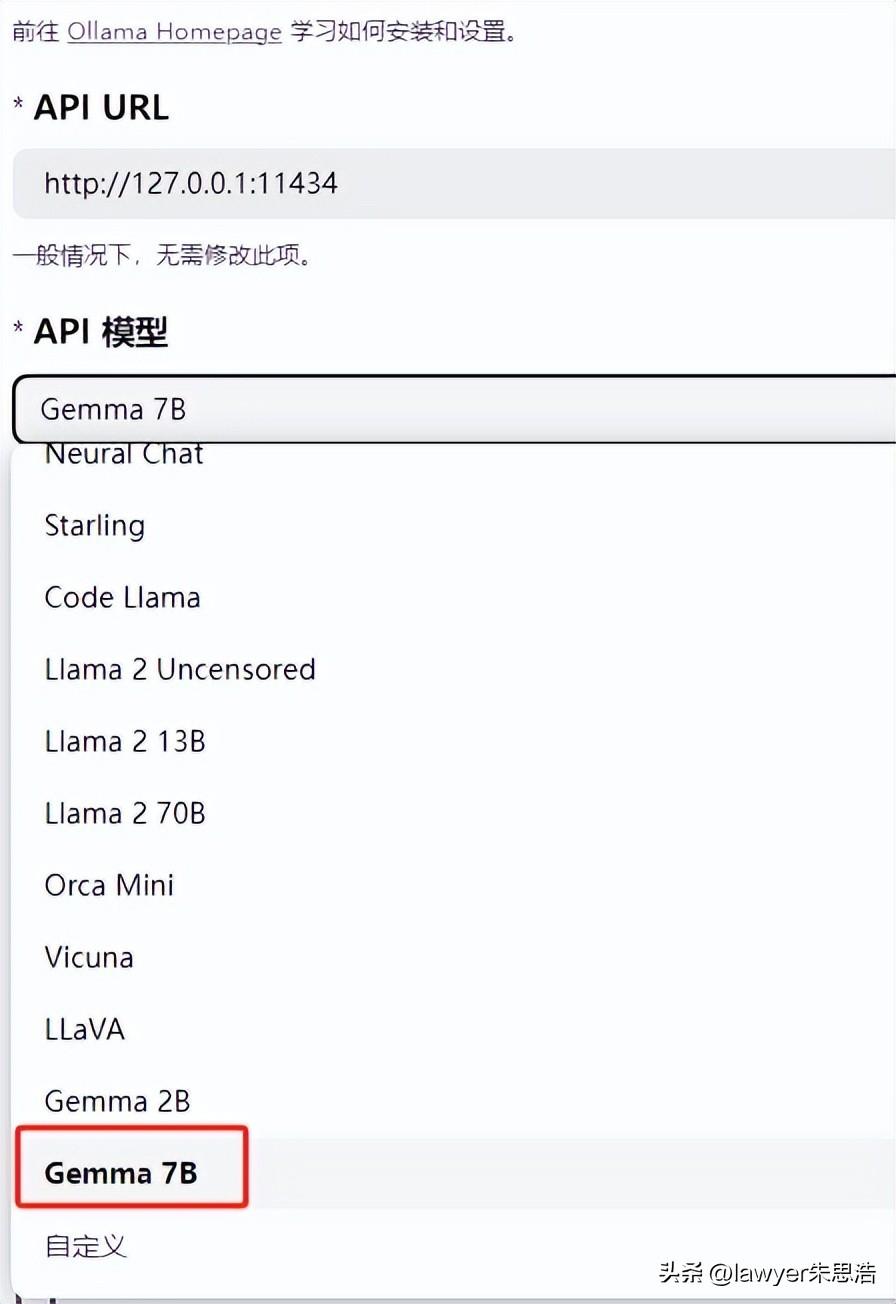

(三)安装和使用openai-translator

双击下载好的OpenAI.Translator_0.3.33_x64-setup.exe文件,按照提示完成安装;安装完成打开后,点击软件界面左下角的⚙️按钮,进入设置页面;

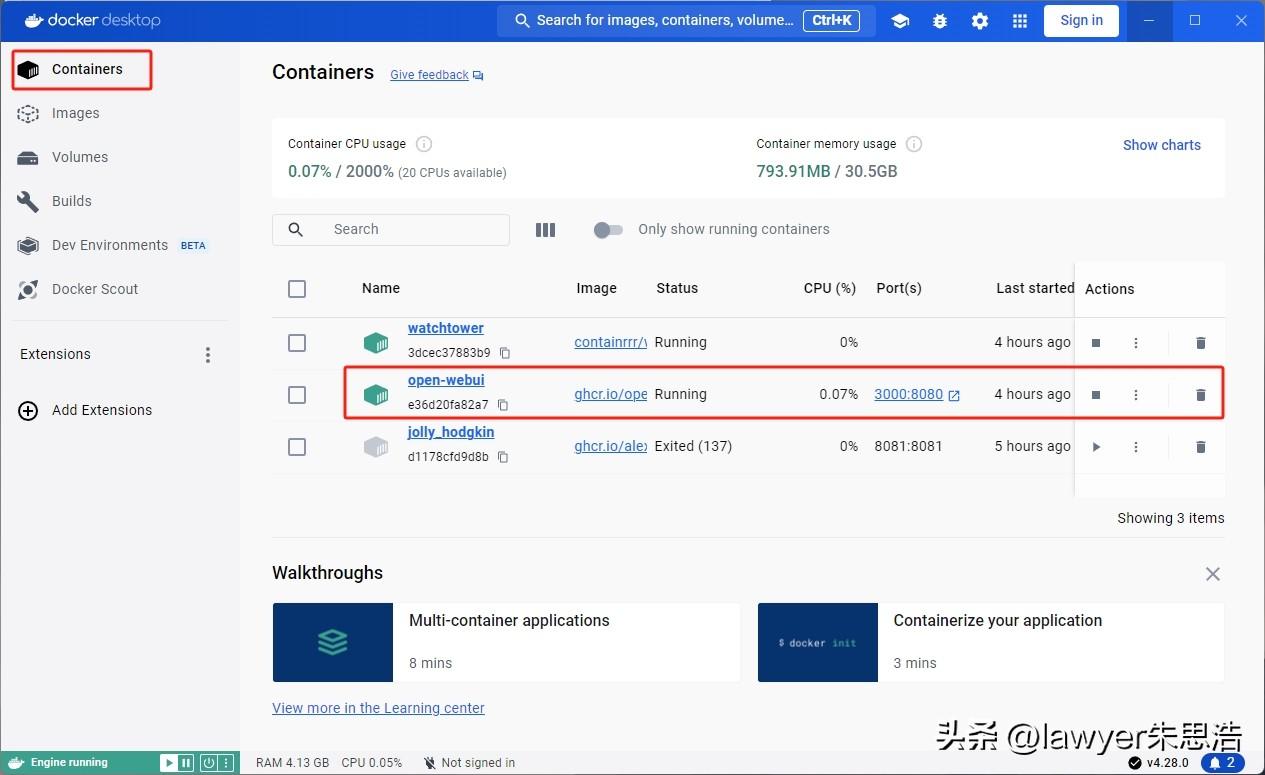

(四)安装和使用Open WebUI

双击下载好的Docker Desktop Installer.exe文件,按照提示完成安装(一路按照默认选项安装并打开就行);右键windows开始按钮,选择“终端”,打开一个新的终端对话框;(如果是mac电脑,直接点击“终端”即可);

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!