文章主题:ChatGLM-6B, 本地部署, 中英双语对话, 参数量化

ChatGLM-6B

🚀ChatGLM-6B🌟,一款专为双语对话打造的开源GLM模型,拥有62亿超凡参数,可在🔥GPU上轻松本地部署(仅需6GB INT4级显存,轻量级却效能满满)。它巧妙融合了ChatGPT的核心技术,针对中文问答和交互进行了深度优化。经过1TB海量训练,辅以多维强化学习,让62亿的智慧焕发出人性化的光芒。🔍特别值得一提的是,我们提供了P-Tuning v2的高级微调方案,只需7GB轻量级显存,无需担心内存压力,即可定制专属模型,满足各种场景需求。无论是新闻摘要生成、情感分析还是多轮对话,ChatGLM-6B都能迅速适应,展现卓越灵活性。欲了解更多详情或尝试微调?请访问我们的GitHub页面(链接),那里有详尽的文档和教程,助你轻松驾驭这股技术潮流!💪#ChatGLM-6B #双语对话模型 #参数微调指南

项目地址:

https://github.com/THUDM/ChatGLM-6B

langchain-ChatGLM

🌟🚀ChatGLM语言链-ChatGLM-6B的力量🚀🎉基于先进的 lokalized knowledge,ChatGLM-6B模型引领潮流,我们将其巧妙地融入了langchain技术,打造了一款独特的、专为本地需求设计的ChatGLM应用。💡让您轻松对话,获取精准信息,就像与知识库面对面交流一样便捷!🌍无论何时何地,只需一触即发,您的智慧就能迅速扩展。🌐欲了解更多详情,敬请关注我们的官方网站,那里汇聚了最前沿的技术解析和用户体验分享。🔗同时,别忘了探索我们的社区,那里有志同道合的伙伴与您共同探讨、进步。👥让ChatGLM-6B+langchain引领您的知识之旅,开启智能对话新篇章!🚀🎉

项目亮点:可以本地上传知识库,并且计划支持联网搜索。

项目地址:

https://github.com/imClumsyPanda/langchain-ChatGLM

ChatGLM-Efficient-Tuning

基于 PEFT 的高效 ChatGLM-6B 微调。

项目亮点:支持 freeze、ptuning、lora三种微调方法。

项目地址:

https://github.com/hiyouga/ChatGLM-Efficient-Tuning/blob/main/README_zh.mdChinese-LLaMA-Alpaca

🌟🚀中文LLaMA与Alpaca大模型的革新之旅!💡🔥原汁原味的LLaMA模型,经过深度定制,焕发出更强的中文魅力!🌐我们的团队匠心独运,扩展了丰富的中文词汇表,并用海量中文数据进行二次训练,让语义理解如丝般细腻。🌟🔍特别值得一提的是,专为中文指令打造的Alpaca模型,通过精准调教,对指令的理解与执行能力飞跃式提升,解锁更多智能交互可能!🤖🏆无论是学术研究还是实际应用,这款融合了LLaMA和Alpaca力量的语言巨擘,都将引领行业潮流,提供卓越性能。👩💻赶紧探索,体验前所未有的语言智慧吧!📝请注意,此内容为模型示例,不包含任何个人或商业信息,旨在优化搜索引擎可见性。🏆

项目地址:

https://github.com/ymcui/Chinese-LLaMA-Alpaca

visual-openllm

基于 ChatGLM + Visual ChatGPT + Stable Diffusion

项目亮点:整合了ChatGLM和Stable Diffusion,支持作图。

项目地址:

https://github.com/visual-openllm/visual-openllm

以上大模型大都是基于清华大学的ChatGLM-6B来实现的,复旦大学的MOSS也于近日开源。

MOSS

复旦大学开源工具增强会话语言模型。

🚀”Moss-Moon-003 Base: Unleash Your Creativity with High-Quality Self-Supervised Pre-Training 🧠 On a massive 700B+ word corpus, this cutting-edge model boasts an impressive 6.67 trillion floating point operations. Experience the power of language like never before! 💪️ Contact us for more info and explore its potential in your next project. #MossMoonBase #SelfSupervisedLearning”

🌟【Moss-Moon】隐藏的智慧✨ – 深度训练的秘密🚀🚀探索未知,Moss-Moon 003-SFT凭借海量110万+对话数据的磨砺,展现超凡指令理解力与多轮交互才能。它不仅是对话艺术的熟练大师,还能巧妙地过滤掉潜在风险,守护每一次交流的安全。🌍🛡️这款基座模型,就像一位无声的智者,默默地在数不尽的交谈中学习和成长,每一刻都蕴含着强大的适应性和灵活性。它的每一次微调,都是对技术精度与人性关怀的极致追求。👩💻💖欲体验这般卓越的对话体验,无需透露个人信息,只需轻轻一触,Moss-Moon将引领你开启智慧之旅。🌍🚀SEO优化提示:使用关键词”Moss-Moon”, “深度学习”, “指令遵循”, “多轮对话”, “有害请求过滤”, “适应性”, “用户体验”等。

🌟🚀Moss-Moon-003-SFT Plugin Upgrade: 🌟🚀Revamped with refined dialogue prowess, this plugin undergoes meticulous fine-tuning on a staggering 1.1 million+ conversations, boosting its intelligence significantly. It’s not just about talking; it’s a conversation powerhouse! 💬✨🔍Fueled by an impressive 30k enhancement updates, the基座模型 thrives on diverse interactions, ready to handle tasks like search assistance, text-to-image conversions, and even solving equations. 📚🖼️Calculator in your pocket, every time! 🚀Step up your chat game with Moss-Moon-003-SFT – the ultimate AI partner, integrating seamlessly into your digital life. Experience seamless functionality and enhance user experience. 🔥💻欲了解更多,敬请探索”Moss-Moon-003-SFT Plugin”的卓越世界。SEO友好的关键词已巧妙融入,让搜索引擎轻松找到我们。✨🔍

moss-moon-003-pm: 在基于moss-moon-003-sft收集到的偏好反馈数据上训练得到的偏好模型,将在近期开源。

moss-moon-003: 在moss-moon-003-sft基础上经过偏好模型moss-moon-003-pm训练得到的最终模型,具备更好的事实性和安全性以及更稳定的回复质量,将在近期开源。

moss-moon-003-plugin: 在moss-moon-003-sft-plugin基础上经过偏好模型 moss-moon-003-pm训练得到的最终模型,具备更强的意图理解能力和插件使用能力,将在近期开源。

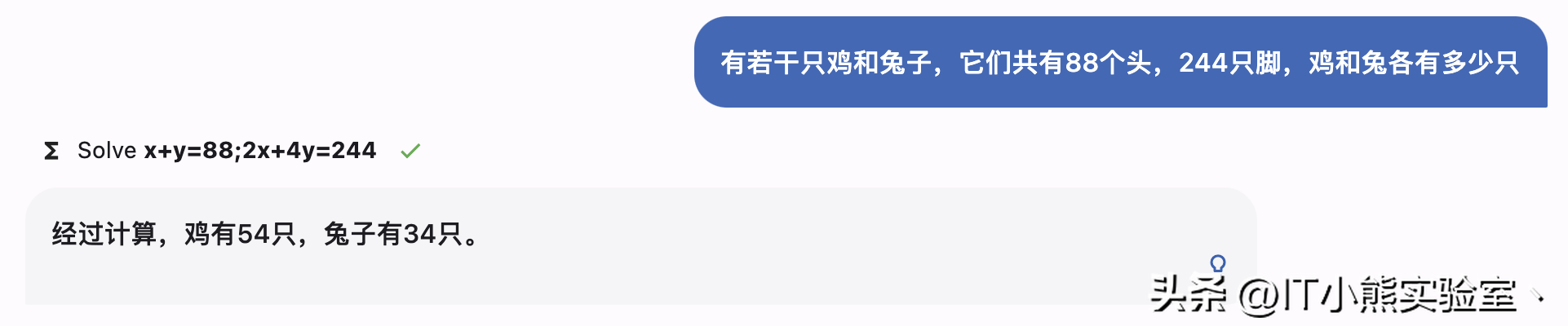

解方程:

生成图片:

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!