现在开源的大模型其实挺多的,今天搭建Gemma这个谷歌开源的大模型,但是你想搭建别的只要你看完你都会了。

介绍

Ollama:一款可以让你在本地快速搭建大模型的工具

官网:https://ollama.com/

github:https://github.com/ollama/ollama

Gemma:谷歌开源的大模型

open-webui:非常不错的大模型webui

github:https://github.com/open-webui/open-webui

开始搭建

第一步选择系统版本:

因为大模型需要的GPU来运算,当然其实CPU也可以,但我们今天讲的是要用GPU来跑的,所以我们在购买服务器的时候,一定要选择GPU服务器,然后看看服务器的系统版本对GPU显卡支持的更好。

这里我选择的是阿里的Alibaba Cloud Linux 3.2104 LTS 64位

第二步部署Ollama:

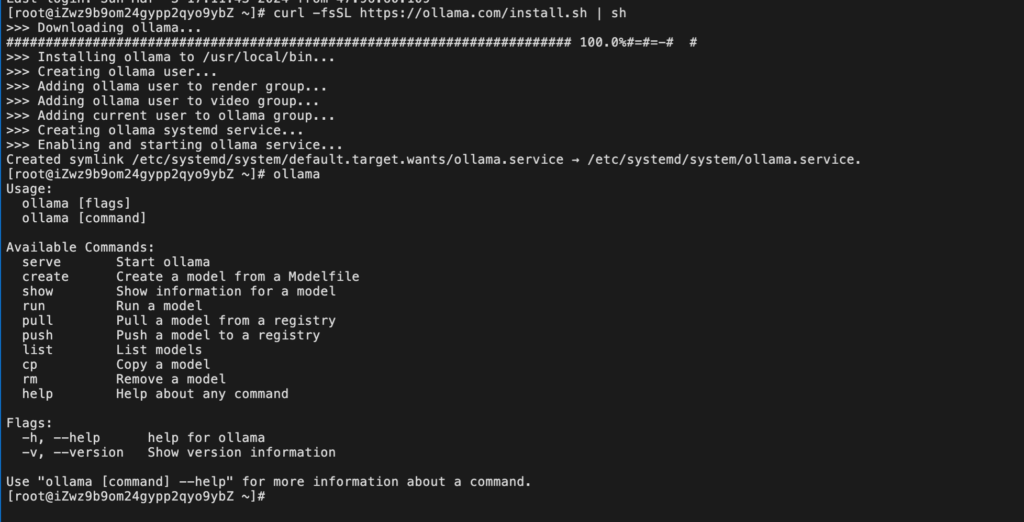

部署ollama非常简单直接输入:

curl -fsSL https://ollama.com/install.sh | sh

等待安装完成后,就如下图:

你还可以输入:ollama 看看一些基本操作

因为我们需要开放API,ollama的开放端口是11434,我们在服务器商那边打开11434端口,然后直接ip:11434进行访问。

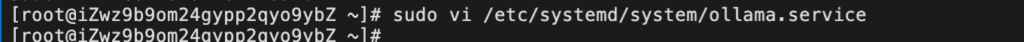

这时候我就发现了ollama的一个坑,我们在成功启动ollama的时候就已经直接占用了11434端口,但是我们直接访问发现是无法访问的,通过防火墙各种排查发现是ollama的配置文件里面出现了问题,解决方法如下:

直接输入:

sudo vi /etc/systemd/system/ollama.service

按i进入插入模式,在ExecStart=/usr/local/bin/ollama serve上面插入:Environment=”OLLAMA_HOST=0.0.0.0:11434″

按ESC再输入:wq回车保存

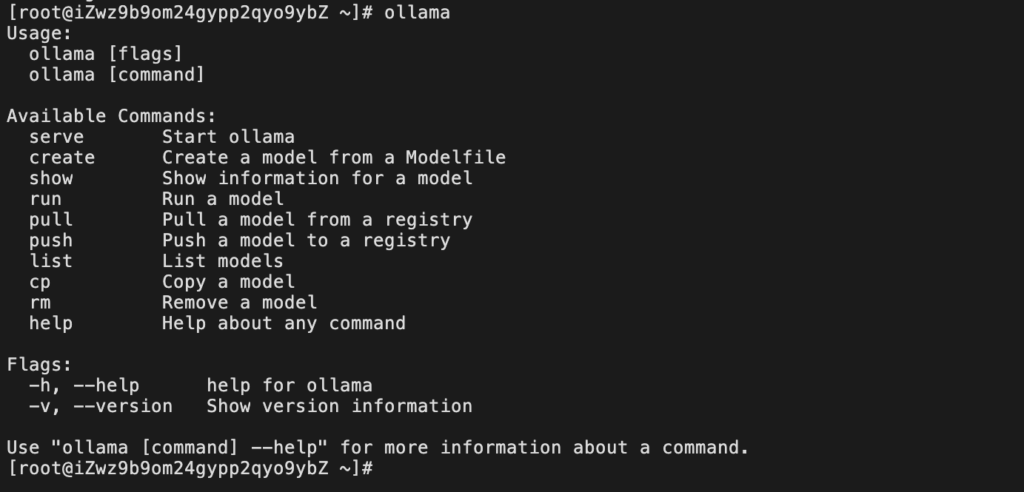

我们直接重启服务器,重启后输入:ollama

然后在打开ip:11434就可以直接访问了

这样就是成功了

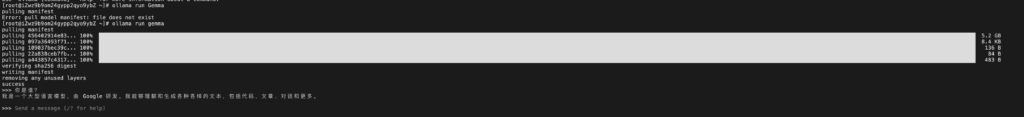

第三步部署:Gemma

gemma是靠ollama来部署的,所以我们直接输入:

ollama run gemma

耐心等待部署完成,如下图:

完成后我们可以直接进行提问,这就好啦!

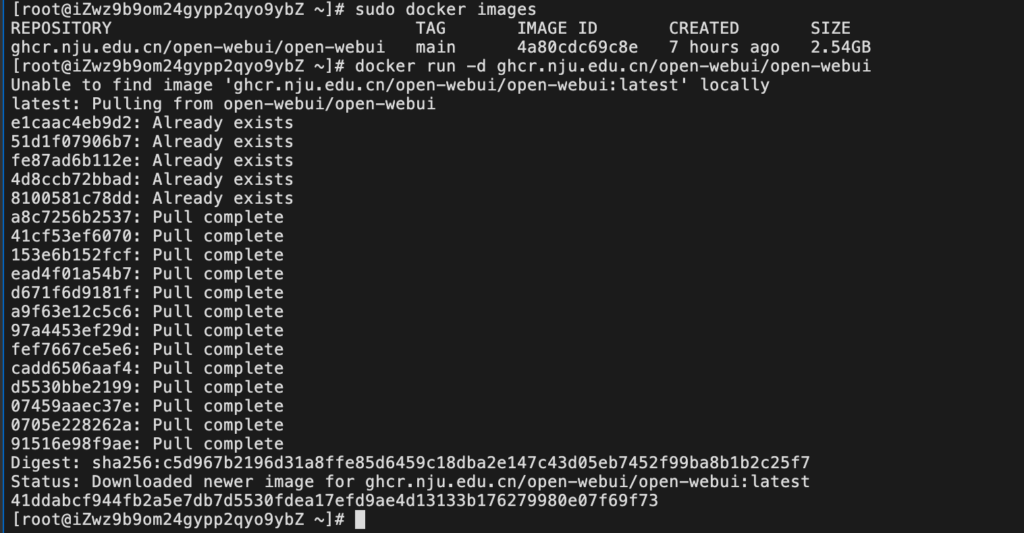

第四步部署:open-webui

因为open-webui是在Docker里面部署的,所以我们需要先部署Docker,因为我是用的阿里云的Alibaba Cloud Linux 3系统,所以我直接是按照阿里云的官方教程来的,建议你们也是按照自己的系统去安装Docker,我就不过多的说了。

安装open-webui直接输入:

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main如果你直接输入的话你就入坑了,如果你的服务器是国内的话,直接下载ghcr.io的镜像简直就是折磨,下一天都不一定下的完,所以我们需要改一下,把ghcr.io改成ghcr.nju.edu.cn再输入:

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.nju.edu.cn/open-webui/open-webui:main

这样就嘎嘎的快,像上面这样就成功了

我们再输入:

sudo docker images查看一下当前的容器,然后再输入我们要启动的容器:

docker run -d ghcr.nju.edu.cn/open-webui/open-webui

如下图:

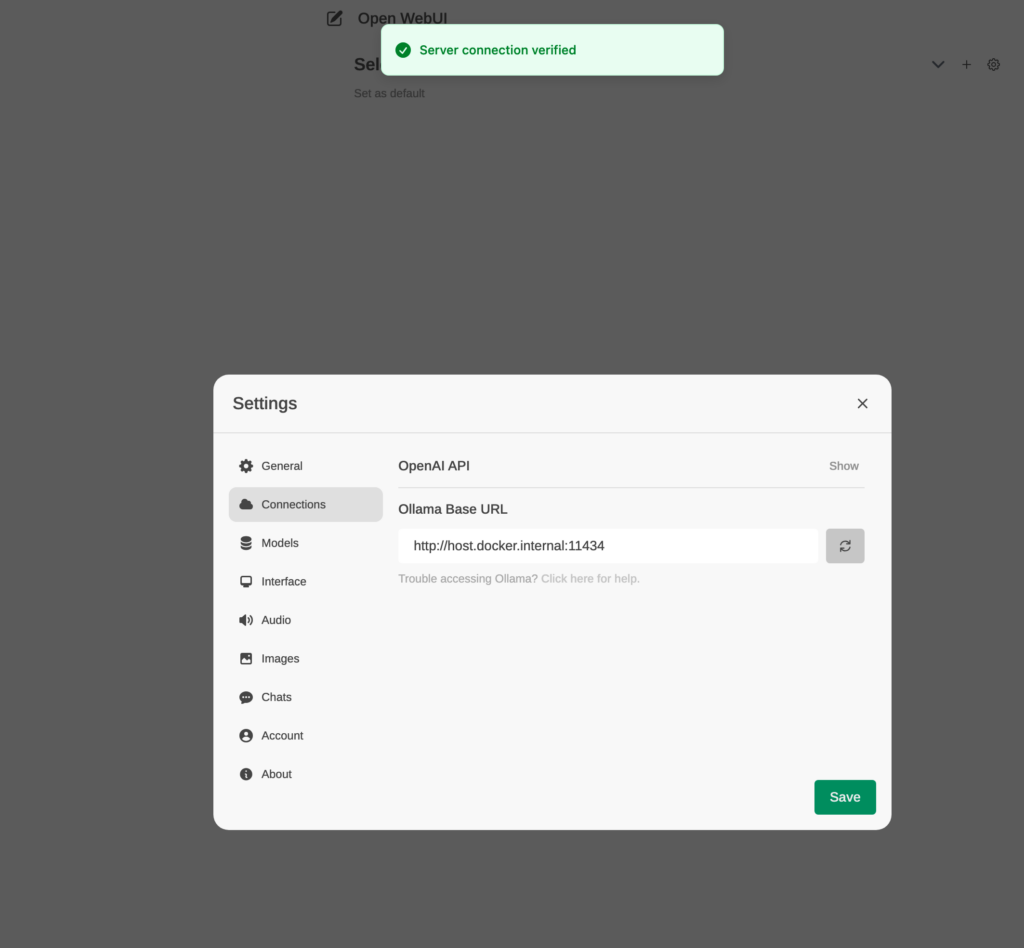

我们再把open-webui的端口3000去打开一下,直接访问IP:3000就可以啦

注册一个账号进去

在设置里面看看ollama连接状态是成功的就好了,直接用起来吧!